Modèles

Trooper.AI propose une variété de modèles logiciels préinstallés conçus pour accélérer la configuration de votre projet. Vous pouvez sélectionner un ou plusieurs modèles lors de la création de votre serveur GPU Blib, ou les ajouter ultérieurement via l'interface de gestion.

Important : Ne définissez pas de port manuel ou ne créez pas de service système pour l'installation d'un modèle. Le modèle s'en chargera pour vous et prendra soin de ces éléments à chaque mise à jour !

Comment ajouter un modèle

Sur votre serveur, cliquez sur le menu d'actions et sélectionnez « Ajouter un modèle » :

Dans la fenêtre contextuelle, cliquez simplement sur le nom du modèle souhaité :

Modifiez maintenant la configuration si nécessaire :

Démarrez l'installation avec le bouton bleu !

Répétez l'opération pour chaque modèle que vous souhaitez installer sur le serveur. Assurez-vous que le GPU dispose de suffisamment de VRAM pour gérer ces modèles et leurs modèles.

Démarrage/Arrêt et débogage d’une installation de modèle

Chaque modèle est géré comme un service système Ubuntu dédié, permettant un contrôle et un débogage faciles. Vous pouvez gérer ces services à l'aide de commandes Linux standard. Par exemple :

sudo service comfyui status

Cette commande récupère le statut actuel du modèle.

sudo service comfyui stop

Cette commande arrête le comfyui service. Substituer comfyui avec le nom du modèle que vous souhaitez gérer. Tous les modèles sont lancés par défaut.

Pour consulter le journal de service, y compris les 100 dernières entrées, utilisez la commande suivante :

sudo journalctl -u comfyui -f -n 100

Utilisez

journalctlpour déboguer efficacement les outils fonctionnant sur votre serveur GPU et identifier les problèmes potentiels.

Procédure d'installation du modèle

Le modèle passe par différentes couleurs indiquant l'état actuel du processus d'installation. Pour en savoir plus, consultez État de l'installation des modèlesMais en général, l'installation du modèle prend de 3 à 10 minutes, en fonction de la taille du téléchargement et des paquets de dépendances déjà installés. Voici à quoi cela devrait ressembler une fois terminé :

Séparation des modèles pour le développement de l'IA

Les templates Trooper.AI sur votre serveur Blib vous permettent d'exécuter plusieurs applications d'IA ou différentes versions de la même application sur un seul serveur sans conflits. Considérez-les comme des conteneurs isolés pour chaque application.

Voici comment cela fonctionne :

- Isolation : Chaque modèle encapsule l'installation nécessaire pour une application d'IA spécifique. Cela signifie que toutes les bibliothèques, dépendances et paramètres requis sont conservés séparément des autres applications sur le serveur.

- Environnements virtuels : Les modèles utilisent des environnements virtuels (comme

venven Python oucondaafin de créer des espaces isolés pour les dépendances de chaque application. Cela empêche les conflits qui peuvent survenir lorsque différentes applications nécessitent différentes versions de la même bibliothèque. - Conteneurs Docker (Facultatif) : Pour un isolement et une portabilité encore plus poussés, les modèles peuvent utiliser des conteneurs Docker. Docker regroupe une application et toutes ses dépendances dans une seule unité, garantissant qu'elle s'exécute de manière cohérente dans différents environnements.

- Données persistantes : Les modèles sont toujours configurés pour stocker les données de manière persistante, ce qui signifie que les données de votre application seront sauvegardées même si le serveur est mis en pause ou redémarré.

Cette approche offre plusieurs avantages :

- Organisation : Maintient votre environnement de développement IA propre et organisé.

- Reproductibilité : Garantit des résultats cohérents en isolant les dépendances.

- Flexibilité : Vous permet de basculer facilement entre différentes applications d'IA ou d'expérimenter avec différentes versions.

- Efficacité des ressources : Maximise l'utilisation des ressources en exécutant plusieurs applications sur un seul serveur.

Modèles de serveurs Blib GPU préconfigurés

Voici un aperçu des modèles disponibles, chacun avec des informations détaillées fournies sur sa page de documentation dédiée :

Modèle ComfyUI pour les Blibs Serveur GPU

Une solution de flux de travail visuel et basée sur des nœuds pour Flux et Stable Diffusion, idéale pour la génération et le prototypage d'images IA avancées.

OpenWebUI & Ollama

Exécutez et gérez des modèles de langage volumineux (LLM) locaux, tels que LLaMA et Gemma, via une interface web conviviale et entièrement privée.

Framepack

Une solution basée sur l'IA qui transforme rapidement et efficacement les images en séquences vidéo fluides et cohérentes.

Ubuntu Desktop

Environnement de bureau Ubuntu complet accessible via xRDP, incluant des pilotes GPU fonctionnels, le navigateur Chrome et la prise en charge d'applications GPU telles que Blender ou DaVinci Resolve. Consultez également le Accès RDP pour obtenir la meilleure connexion rapide à l'interface utilisateur.

InvokeAI

Un éditeur d'images basé sur un navigateur avec des fonctionnalités avancées, notamment le multi-prompting, le téléchargement intégré des modèles Flux, et bien plus encore.

Automatic1111 pour SDXL

Déployez rapidement des flux de travail Stable Diffusion en utilisant la version compatible SDXL d'Automatic1111 – idéal pour la génération d'images de haute qualité à partir d'invites textuelles.

Jupyter Notebook

Des notebooks Python interactifs entièrement accélérés par GPU, idéaux pour la science des données, les flux de travail d'apprentissage automatique et le prototypage rapide.

Qdrant

Base de données vectorielle évolutive conçue pour la recherche de similarité haute performance, permettant une récupération efficace pour les applications d'IA et l'analyse avancée des données.

n8n

Une plateforme d'automatisation de flux de travail sans code vous permettant de connecter des applications et d'automatiser des tâches - idéale pour la création de pipelines et d'intégrations d'IA personnalisés.

Tout Docker

Modèle flexible basé sur Docker pour lancer facilement des images Docker compatibles GPU.

Proxy web avec SSL

Le proxy web inclut un certificat SSL public, permettant un routage sécurisé du trafic sur Internet à partir d'un port interne.

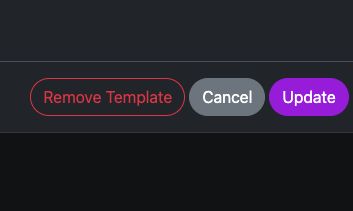

Supprimer un modèle

Vous pouvez supprimer un modèle en cliquant sur le bouton « Supprimer le modèle » dans sa configuration (accessible via l'icône d'engrenage sur la ligne d'installation du modèle dans le tableau de bord Blib – voir capture d'écran). Cette action supprime uniquement la configuration du modèle ; tout logiciel ou service associé reste intact et doit être supprimé manuellement. Vos données restent sécurisées tout au long de ce processus.

Demande de modèles supplémentaires

Si vous avez besoin de modèles supplémentaires ou de configurations personnalisées, veuillez contacter notre équipe d'assistance par e-mail ou WhatsApp, en incluant l'URL du dépôt GitHub pertinent. Notre équipe configurera rapidement l'environnement demandé.

Pour une assistance supplémentaire ou des demandes personnalisées, veuillez nous contacter à : Contacts Support

🔒 Considérations relatives à l'authentification

Veuillez accorder la priorité à la sécurité de votre serveur. Bien que des applications telles qu'OpenWebUI et n8n incluent des fonctionnalités d'authentification, ComfyUI et Automatic1111 offrent des options d'authentification configurables – veuillez consulter leur documentation officielle pour connaître les détails de mise en œuvre. D'autres applications, telles qu'InvokeAI, peuvent ne pas disposer d'authentification intégrée. N'oubliez pas que la sécurité de votre serveur est de votre responsabilité. Posez-nous toutes vos questions : Contacts Support