OpenWebUI & Ollama

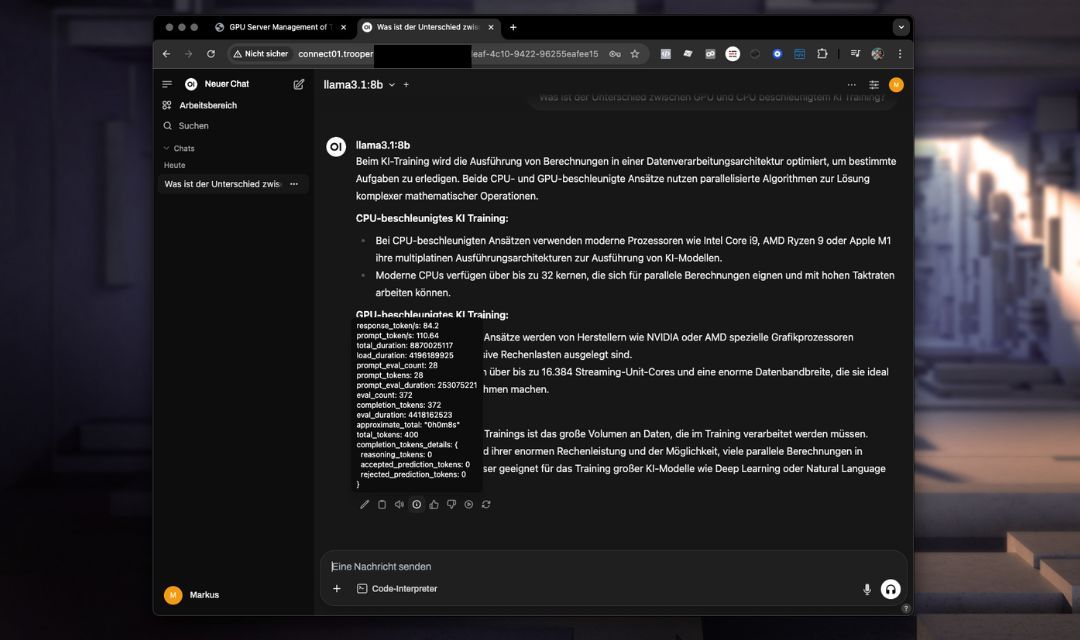

Le OpenWebUI & Ollama Ce modèle fournit une interface de chat IA auto-hébergée et préconfigurée avec une intégration directe de modèles de langage puissants tels que Llama ou DeepSeek via Ollama Il comprend une configuration optimisée pour un fonctionnement transparent sans configuration supplémentaire.

Ce modèle utilise les capacités avancées de l'API d'OpenWebUI, offrant une gestion améliorée des conversations, la persistance du contexte et une intégration rationalisée par rapport à l'API plus simple d'Ollama.

Vous pouvez spécifier la version d'OpenWebUI à installer. La valeur par défaut est notre version la plus récemment testée ; cependant, vous êtes libre de la mettre à niveau ou de la rétrograder si nécessaire. Indiquez simplement la version souhaitée dans la valeur de configuration lors de l'installation du modèle.

Fonctionnalités et Capacités

- Interface Web AvancéeExpérience de chat intuitive accessible directement depuis votre navigateur.

- Fonctionnalités API amélioréesAmélioration de la gestion des contextes de chat et intégration plus facile avec les applications externes.

- Utilisation optimisée du modèleModèles préinstallés prêts à l'emploi.

- Environnement intégréEnvironnement entièrement préconfiguré incluant les paramètres de port et les configurations nécessaires.

- Sécurisé et personnalisableConfiguration simple pour des identifiants sécurisés et des paramètres spécifiques à l'utilisateur.

Installation

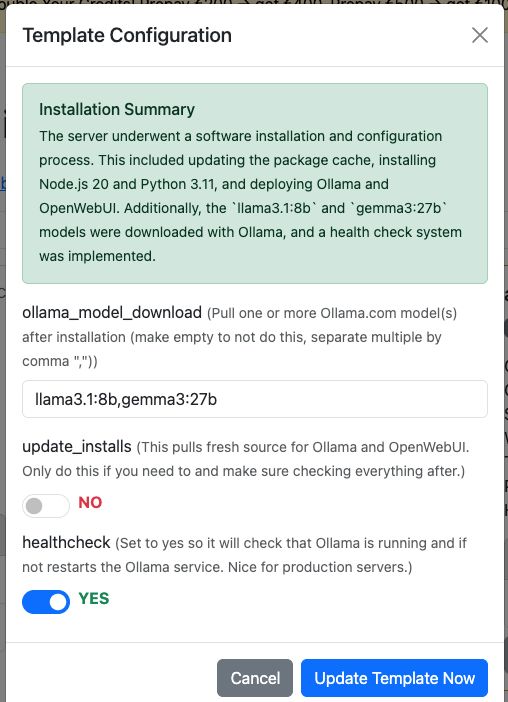

Il suffit d'ajouter le modèle “OpenWebUI & Ollama” à votre serveur GPU Trooper.AI et l'installation se fera complètement automatiquement. Si vous le souhaitez, il peut également télécharger directement vos modèles depuis Ollama. Vous pouvez les configurer dans le dialogue de Configuration du Modèle.

Mais bien sûr, vous pouvez toujours télécharger des modèles via OpenWebUI après l'installation.

Options supplémentaires :

-

Mettre à jour les installations :

Cette option récupère la dernière source pour Ollama et OpenWebUI. N'utilisez-la que si nécessaire, et assurez-vous de tout vérifier par la suite.

Bien sûr, vous pouvez également effectuer des mises à jour manuelles via le terminal, mais n'oubliez pas d'installer les dépendances également.

Cette fonction gère tout pour vous – pratique et automatisé ! -

Activer la vérification de l'état :

Réglez ceci suryespour activer une vérification de l'état de santé qui garantit que le service Ollama est en cours d'exécution et répond via son API interne.

Si ce n'est pas le cas, la vérification de l'état de santé redémarre automatiquement le service.

Le script est situé à/usr/local/bin/ollama-health.sh, et le service peut être contrôlé avec :

sudo service ollama-health stop/start/status.

Ceci est particulièrement utile pour les serveurs de production.

Accéder à OpenWebUI

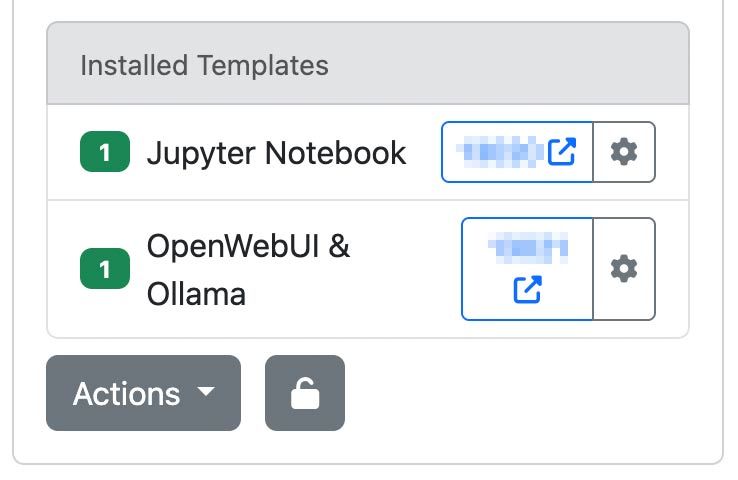

Après avoir déployé votre instance de serveur Trooper.AI avec le modèle OpenWebUI & Ollama, accédez-y via votre URL et votre port désignés :

http://your-hostname.trooper.ai:assigned-port

Ou cliquez sur le numéro de port bleu à côté du modèle OpenWebUI :

Vous configurerez les identifiants de connexion initiaux lors de votre première connexion. Assurez-vous de conserver ces identifiants en lieu sûr, car ils seront nécessaires pour les accès ultérieurs.

Cas d'utilisation recommandés

Le modèle OpenWebUI & Ollama est idéal pour :

- Collaboration en équipe via chat IA

- Déploiements d'assistants IA personnels

- Développement et prototypage rapides d'applications d'IA conversationnelle

- Utilisation de l'API et création/connexion d'agents en remplacement de l'API OpenAI

- À des fins éducatives et de recherche

LLM à tester

À notre humble avis, voici quelques modèles pour vous aider à démarrer :

- GPT-OSS : Le modèle open-weight d'OpenAI, adapté au raisonnement, aux tâches agentiques et au développement. S'exécute efficacement sur les instances Explorer, Conqueror (16 Go de VRAM) et Sparbox (24 Go de VRAM). https://ollama.com/library/gpt-oss:20b

- DeepSeek-R1: Un modèle de raisonnement ouvert performant comparable à O3 et Gemini 2.5 Pro. Optimisé pour les machines StellarAI avec 48 Go de VRAM. https://ollama.com/library/deepseek-r1:70b

- Gemma 3 : Actuellement l'un des modèles les plus performants pour une utilisation sur GPU unique. Alimente James de Trooper.AI sur les instances Sparbox. https://ollama.com/library/gemma3:27b

Trouvez plus de LLM ici : https://ollama.com/search (Tous sont compatibles avec OpenWebUI !)

Considérations techniques

Configuration requise

Assurez-vous que l'utilisation de la VRAM de votre modèle ne dépasse pas 85 % de la capacité afin d'éviter une dégradation significative des performances.

- VRAM GPU recommandée : 24 Go

- Stockage : au moins 180 Go d'espace disponible

Environnement préconfiguré

- Ollama et OpenWebUI sont préinstallés et entièrement intégrés.

- Les paramètres de port et toutes les configurations nécessaires sont déjà établis, ne nécessitant aucune configuration manuelle supplémentaire.

- Les répertoires d'installation et les variables d'environnement sont prédéfinis pour une utilisation immédiate.

Persistance des données

Toutes vos interactions de chat, les configurations des modèles et les paramètres utilisateur sont stockés en toute sécurité sur votre serveur.

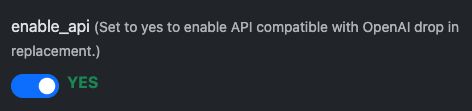

Connexion via une API compatible OpenAI

OpenWebUI fournit une interface API compatible OpenAI, permettant une intégration transparente avec les outils et les applications qui prennent en charge le format OpenAI. Cela permet aux développeurs d'interagir avec des modèles auto-hébergés comme llama3 comme s'ils communiquaient avec l'API OpenAI officielle, ce qui est idéal pour intégrer l'IA conversationnelle dans vos services, scripts ou flux d'automatisation.

Premiers pas : Préparation

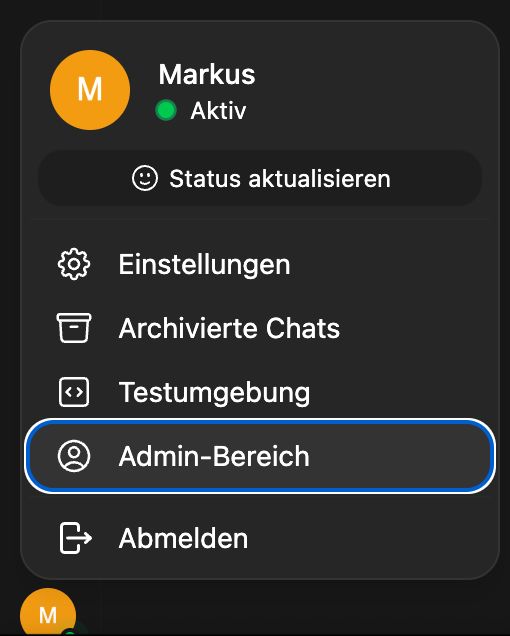

L'API est activée par défaut, mais vérifiez dans la configuration du modèle :

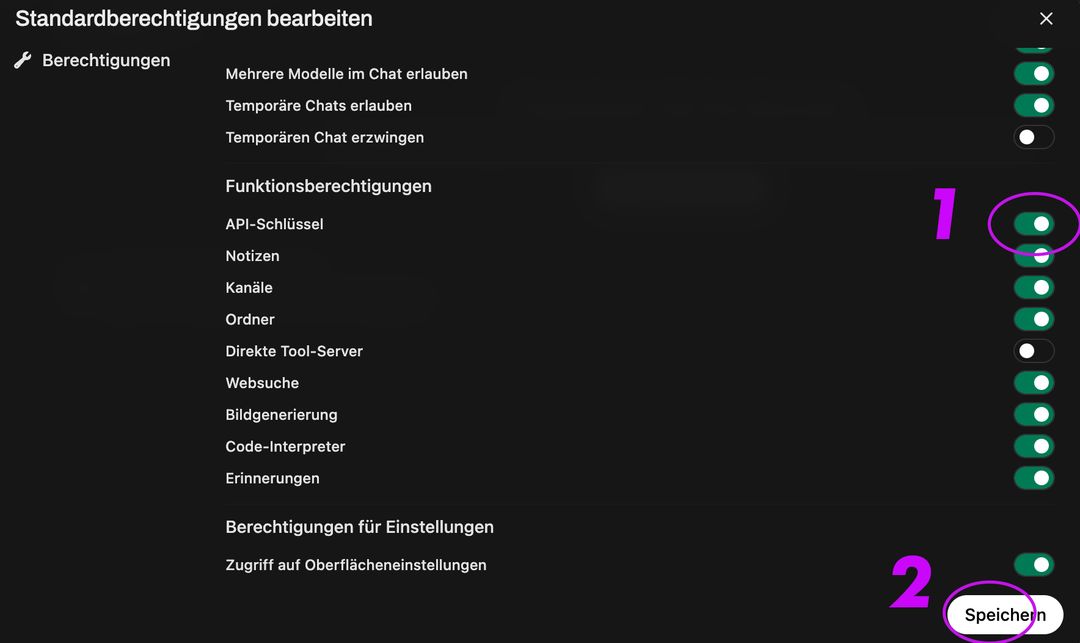

Après cela, activez la création de clés API pour tous les utilisateurs :

Ensuite, allez dans Groupe et Groupe par défaut, activez la création de clé API, cliquez sur enregistrer :

Cela activera le point de terminaison :

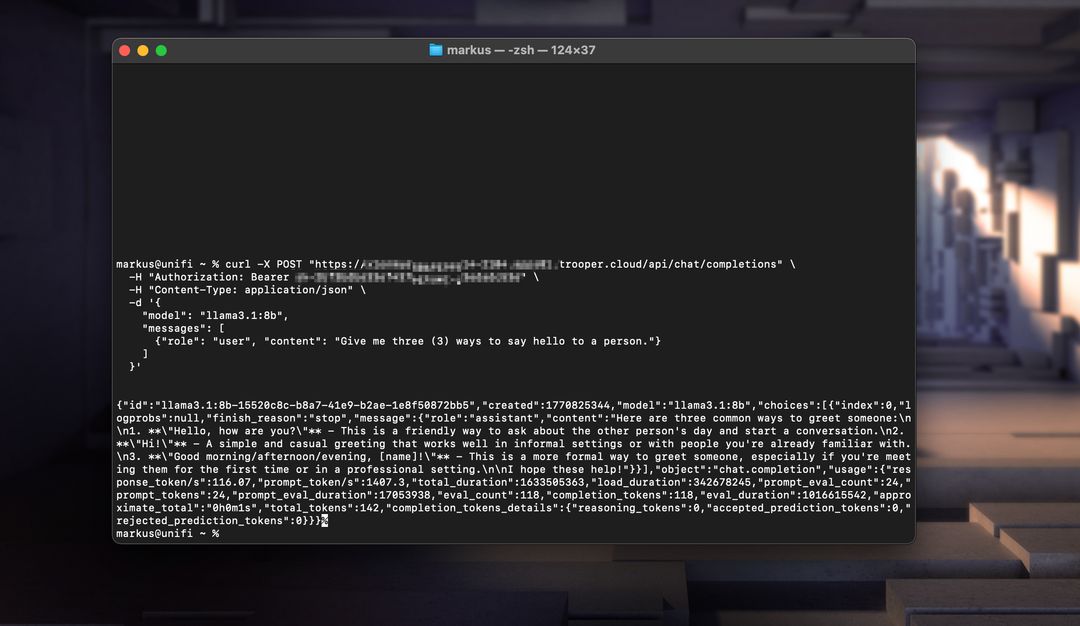

Voici deux exemples fonctionnels : un utilisant Node.js et l'autre utilisant curl.

Exemple Node.js

const axios = require('axios');

const response = await axios.post('https://your-secure-hostname.trooper.ai/api/chat/completions', {

model: 'llama3',

messages: [{ role: 'user', content: 'Hello, how are you?' }],

}, {

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_API_KEY'

}

});

console.log(response.data);

Assurez-vous que les appels d'API utilisent

/api/...plutôt que/v1/...car c'est le format requis pour OpenWebUI.

Exemple cURL

curl https://your-secure-hostname.trooper.ai/api/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "Hello, how are you?" }

]

}'

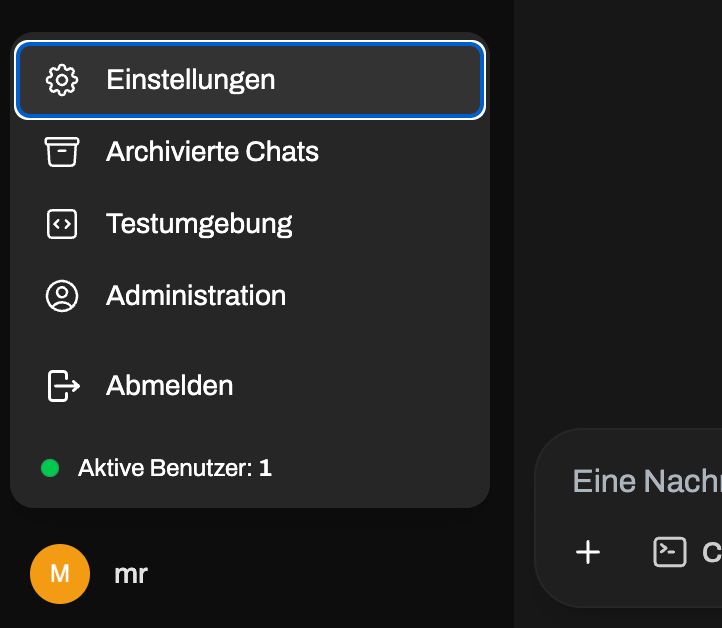

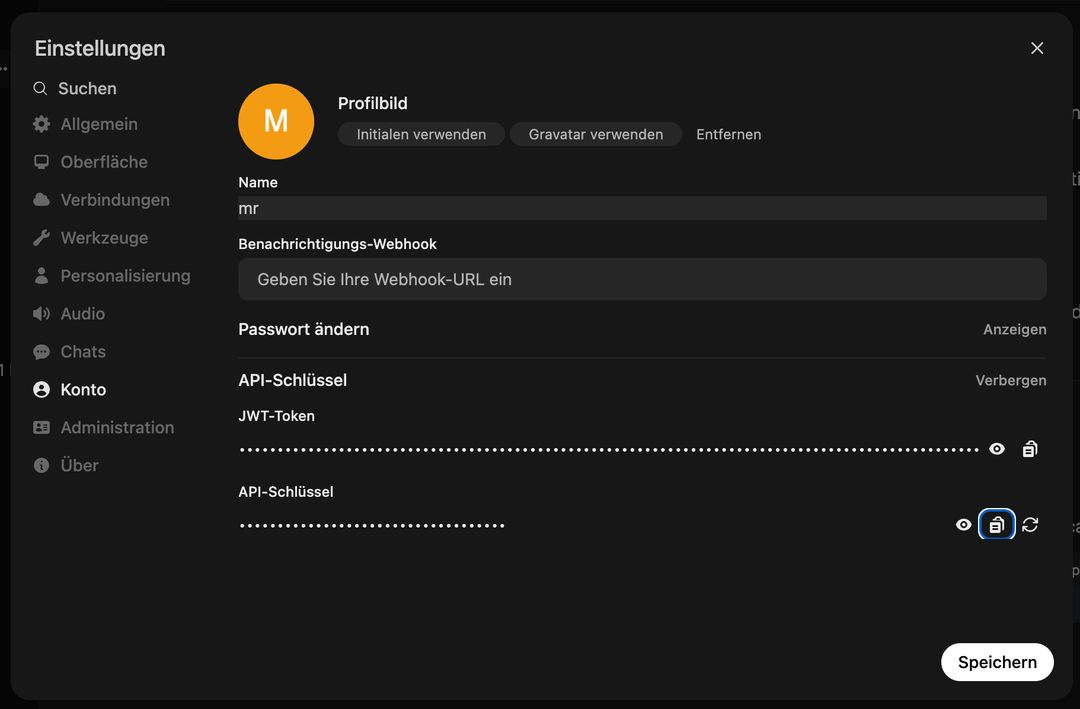

Remplacez YOUR_API_KEY avec le jeton réel généré dans l'interface OpenWebUI sous Utilisateur → Paramètres → Compte → Clés APINe vous connectez pas au panneau d'administration, l'accès à l'API est spécifique à l'utilisateur ! Voir ici :

Après cela, allez ici :

Vous pouvez utiliser cette API avec des outils tels que LangChain, N8N, FlowWise, NodeJS-OpenAI, LlamaIndex, ou tout code base supportant la spécification de l'API OpenAI.

Mises à jour manuelles

Si vous ne souhaitez pas effectuer la mise à jour via le système de modèles, vous pouvez exécuter à tout moment les commandes suivantes pour mettre à jour à la fois OpenWebUI et Ollama :

# Update OpenWebUI:

# 1. Zum OpenWebUI-Verzeichnis wechseln

cd /home/trooperai/openwebui

# 2. Repository aktualisieren

git pull

# 3. Frontend-Abhängigkeiten installieren und neu bauen

npm install

npm run build

# 4. Backend: Python-Venv aktivieren

cd backend

source venv/bin/activate

# 5. Pip aktualisieren & Abhängigkeiten neu installieren

pip install --upgrade pip

pip install -r requirements.txt -U

# 6. OpenWebUI systemd-Dienst neu starten

sudo systemctl restart openwebui.service

# (optional) Update Ollama:

curl -fsSL https://ollama.com/install.sh | sh

sudo systemctl restart ollama.service

Support et documentation complémentaires

Pour obtenir de l’aide à l’installation, à la configuration ou au dépannage, veuillez contacter directement l’assistance Trooper.AI :

- Courriel : support@trooper.ai

- WhatsApp : +49 6126 9289991

Ressources supplémentaires et guides de configuration avancés :