OpenWebUI & Ollama

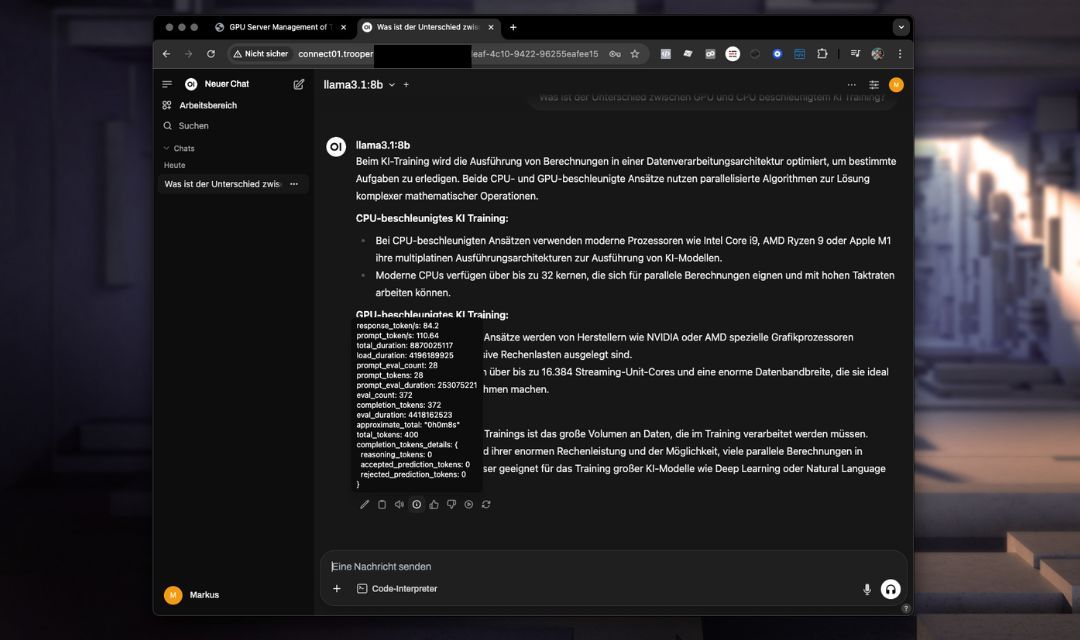

De OpenWebUI & Ollama template biedt een vooraf geconfigureerde, self-hosted AI-chatinterface met directe integratie van krachtige taalmodellen zoals Llama of DeepSeek via Ollama Het bevat een geoptimaliseerde installatie voor naadloze werking zonder extra configuratie.

Deze template maakt gebruik van de geavanceerde API-mogelijkheden van OpenWebUI, waardoor verbeterd gespreksbeheer, contextbehoud en gestroomlijnde integratie mogelijk is in vergelijking met de eenvoudigere API van Ollama.

U kunt de versie van OpenWebUI die u wilt installeren specificeren. De standaardwaarde is onze meest recent geteste versie; u kunt echter upgraden of downgraden indien nodig. Voer eenvoudig de gewenste versie in tijdens de template-installatie.

Belangrijkste kenmerken en mogelijkheden

- Geavanceerde webinterface: Intuïtieve chatervaring toegankelijk rechtstreeks via uw browser.

- Verbeterde API-mogelijkheden: Verbeterd beheer van chatcontexten en eenvoudigere integratie met externe applicaties.

- Geoptimaliseerd modelgebruikVooraf geïnstalleerde modellen, direct klaar voor gebruik.

- Geïntegreerde omgeving: Volledig vooraf geconfigureerde omgeving inclusief poortinstellingen en noodzakelijke configuraties.

- Beveiligd en aanpasbaarEenvoudige installatie voor veilige inloggegevens en gebruikersspecifieke instellingen.

Installatie

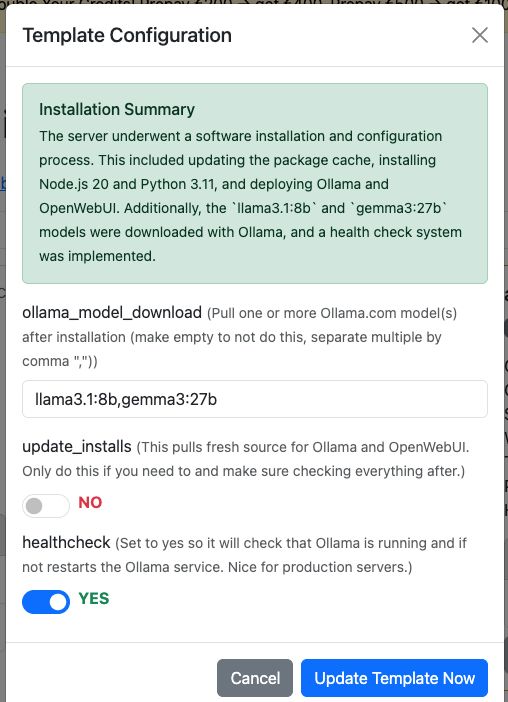

Voeg eenvoudig de template “OpenWebUI & Ollama” toe aan je Trooper.AI GPU Server en de installatie verloopt volledig automatisch. Indien gewenst kan het ook direct je modellen van ollama downloaden. Je kunt ze configureren in het Template Configuratie dialoogvenster.

Maar natuurlijk kun je na de installatie nog steeds modellen downloaden via de OpenWebUI.

Aanvullende opties:

-

Installeer updates:

Deze optie haalt de nieuwste broncode voor Ollama en OpenWebUI op. Gebruik dit alleen indien nodig en controleer alles daarna.

Natuurlijk kunt u ook handmatig updates uitvoeren via de terminal, maar vergeet niet om ook de afhankelijkheden te installeren.

Deze functie regelt alles voor u – handig en geautomatiseerd! -

Activeer Health Check:

Stel dit in opyesom een health check in te schakelen die ervoor zorgt dat de Ollama service actief is en reageert via de interne API.

Zo niet, dan start de health check de service automatisch opnieuw.

Het script bevindt zich op/usr/local/bin/ollama-health.shen de service kan worden beheerd met:

sudo service ollama-health stop/start/status.

Dit is vooral handig voor productieomgevingen.

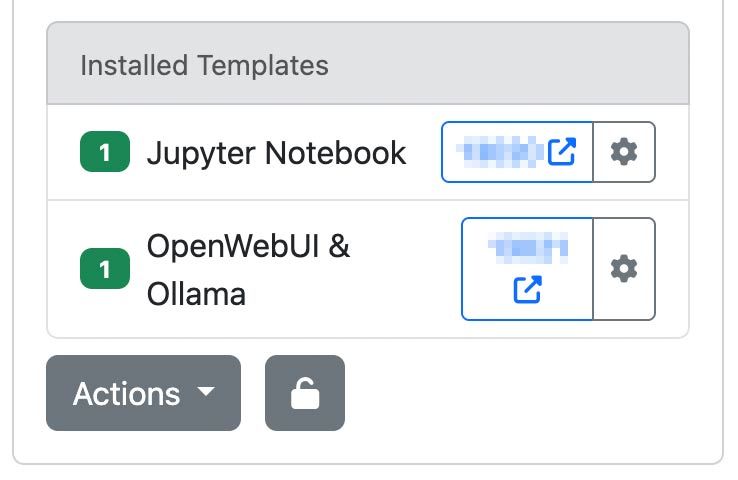

OpenWebUI openen

Nadat u uw Trooper.AI serverinstantie met de OpenWebUI & Ollama template heeft geïmplementeerd, kunt u deze openen via uw aangewezen URL en poort:

http://your-hostname.trooper.ai:assigned-port

Of klik op het blauwe poortnummer naast de OpenWebUI Template:

U configureert de initiële inloggegevens bij uw eerste verbinding. Zorg ervoor dat deze gegevens veilig worden opgeslagen, aangezien ze vereist zullen zijn voor latere toegang.

Aanbevolen toepassingsgebieden

De OpenWebUI & Ollama template is ideaal voor:

- Teamsamenwerking via AI-chat

- Persoonlijke AI-assistent implementaties

- Snelle ontwikkeling en prototyping van conversationele AI-applicaties

- API-gebruik en het bouwen/aansluiten van agents als vervanging voor de OpenAI API

- Educatieve doeleinden en onderzoekswerkzaamheden

LLM's die u zou moeten uitproberen

Naar onze mening - hier zijn een paar modellen om mee te beginnen:

- GPT-OSS: OpenAI’s open-weight model, geschikt voor redeneren, agent-taken en ontwikkeling. Draait efficiënt op Explorer, Conqueror (16 GB VRAM) en Sparbox (24 GB VRAM) instances. https://ollama.com/library/gpt-oss:20b

- DeepSeek-R1: Een hoogpresterend open redeneermodel vergelijkbaar met O3 en Gemini 2.5 Pro. Geoptimaliseerd voor StellarAI machines met 48 GB VRAM. https://ollama.com/library/deepseek-r1:70b

- Gemma 3: Momenteel een van de meest capabele modellen voor single GPU gebruik. Drives Trooper.AI’s James op Sparbox instances. https://ollama.com/library/gemma3:27b

Vind hier meer LLM's: https://ollama.com/search (Deze zijn allemaal compatibel met OpenWebUI!)

Technische Overwegingen

Systeemvereisten

Zorg ervoor dat het VRAM-gebruik van uw model 85% capaciteit niet overschrijdt om significante prestatievermindering te voorkomen.

- Aanbevolen GPU VRAM: 24 GB

- Opslag: Minimaal 180 GB vrije ruimte

Voorgeconfigureerde omgeving

- Ollama en OpenWebUI zijn vooraf geïnstalleerd en volledig geïntegreerd.

- Poortinstellingen en alle benodigde configuraties zijn al ingesteld, waardoor er geen verdere handmatige instelling nodig is.

- Installatiemappen en omgevingsvariabelen zijn vooraf gedefinieerd voor onmiddellijk gebruik.

Gegevenspersistentie

Alle chatinteracties, modelconfiguraties en gebruikersinstellingen worden veilig op uw server bewaard.

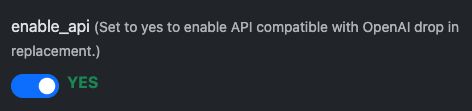

Verbinden via OpenAI-compatibele API

OpenWebUI biedt een OpenAI-compatibele API-interface, waardoor naadloze integratie met tools en applicaties die het OpenAI-formaat ondersteunen mogelijk is. Hierdoor kunnen ontwikkelaars communiceren met zelf-gehoste modellen zoals llama3 alsof ze communiceren met de officiële OpenAI API – ideaal voor het integreren van conversationele AI in uw services, scripts of automatiseringsworkflows.

Eerste stappen: Voorbereiding

De API is standaard ingeschakeld, maar controleer dit in de templateconfiguratie:

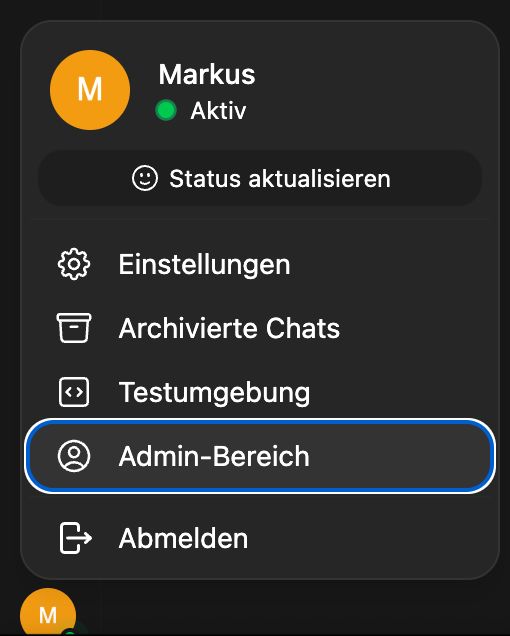

Schakel daarna de API-sleutelcreatie voor alle gebruikers in:

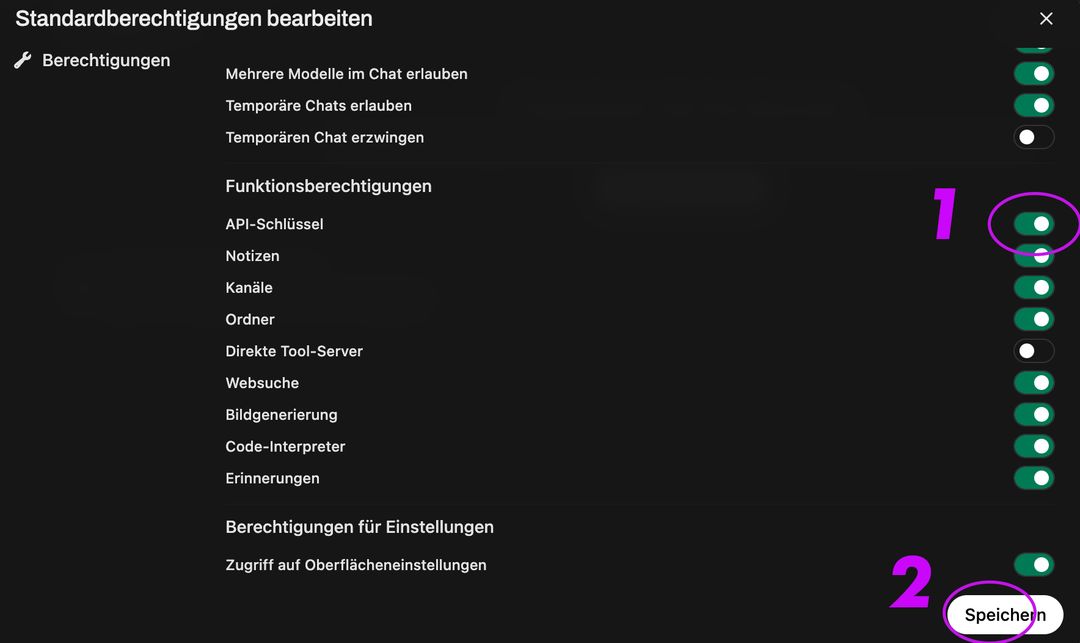

Ga vervolgens naar Groep en Standaardgroep, activeer API-sleutelcreatie en klik op opslaan:

Dit activeert de Endpoint:

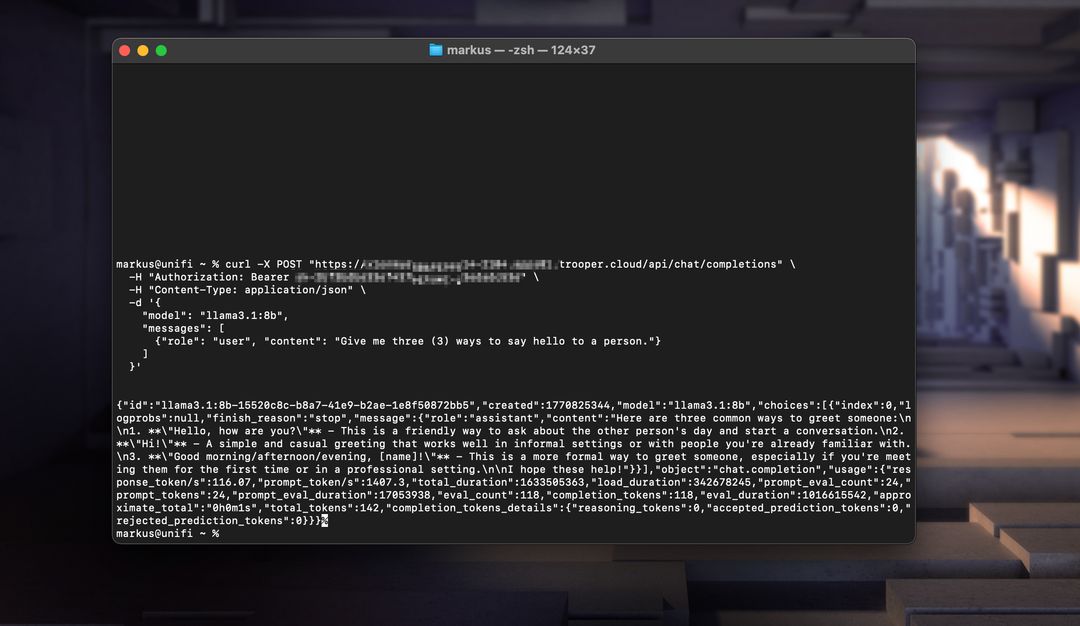

Hieronder volgen twee werkende voorbeelden: één met Node.js en de andere met curl.

Node.js Voorbeeld

const axios = require('axios');

const response = await axios.post('https://your-secure-hostname.trooper.ai/api/chat/completions', {

model: 'llama3',

messages: [{ role: 'user', content: 'Hello, how are you?' }],

}, {

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_API_KEY'

}

});

console.log(response.data);

Zorg ervoor dat API-aanroepen /api/... gebruiken in plaats van /v1/... omdat dit het vereiste formaat is voor OpenWebUI.

/api/...in plaats van/v1/...aangezien dit het vereiste formaat is voor OpenWebUI.

cURL Voorbeeld

curl https://your-secure-hostname.trooper.ai/api/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "Hello, how are you?" }

]

}'

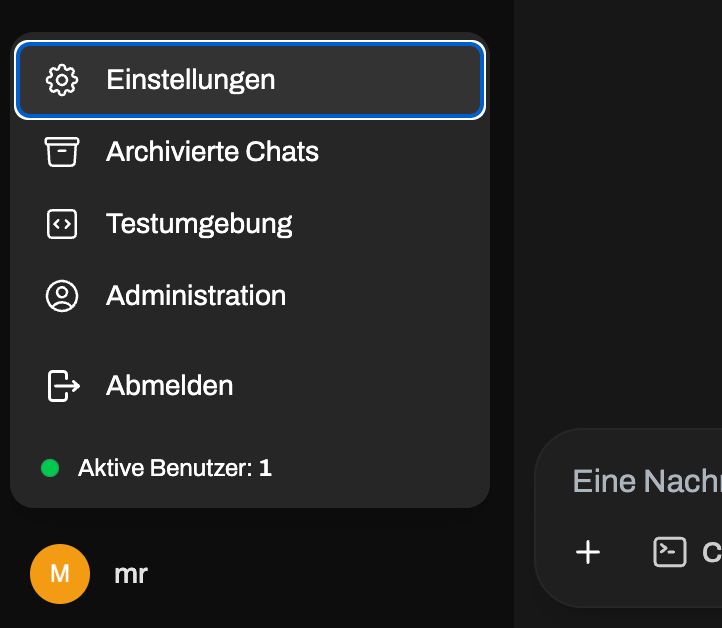

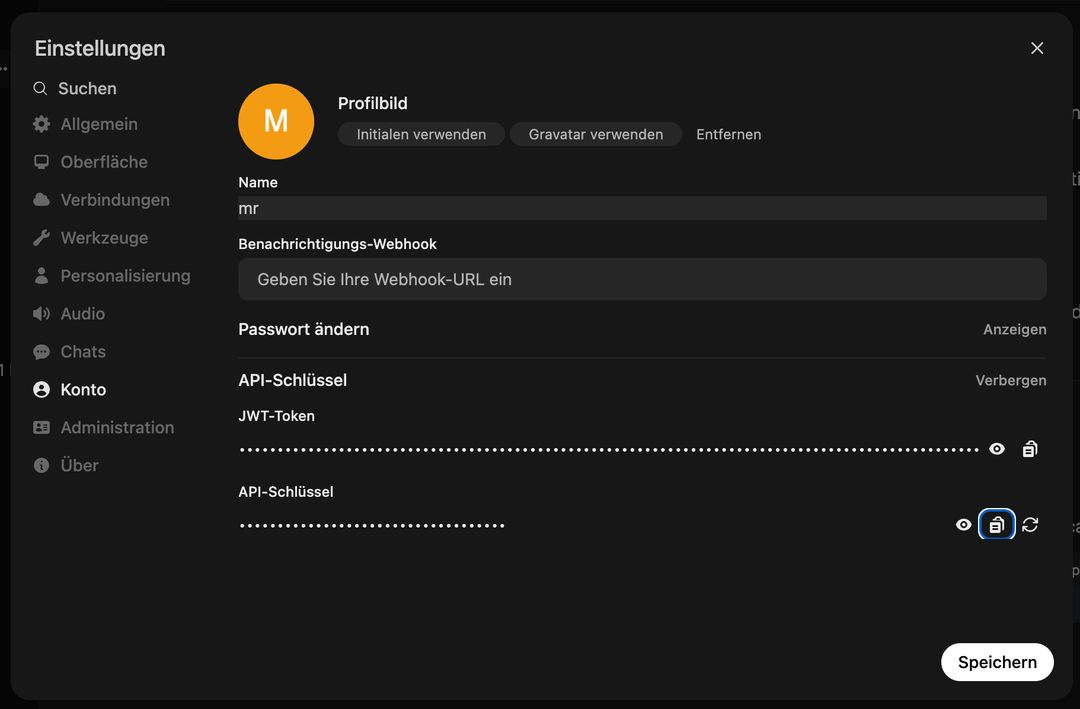

Vervang YOUR_API_KEY met het daadwerkelijke token gegenereerd in de OpenWebUI interface onder Gebruiker → Instellingen → Account → API SleutelsGa niet naar het adminpaneel, de API-toegang is gebruikersspecifiek! Zie hier:

Ga hierna naar:

U kunt deze API gebruiken met tools zoals LangChain, N8N, FlowWise, NodeJS-OpenAI, LlamaIndex, of elke codebase die de OpenAI API-specificatie ondersteunt.

Handmatige Updates

Als u niet via het templatesysteem wilt bijwerken, kunt u op elk moment de volgende commando's uitvoeren om zowel OpenWebUI als Ollama bij te werken:

# Update OpenWebUI:

# 1. Zum OpenWebUI-Verzeichnis wechseln

cd /home/trooperai/openwebui

# 2. Repository aktualisieren

git pull

# 3. Frontend-Abhängigkeiten installieren und neu bauen

npm install

npm run build

# 4. Backend: Python-Venv aktivieren

cd backend

source venv/bin/activate

# 5. Pip aktualisieren & Abhängigkeiten neu installieren

pip install --upgrade pip

pip install -r requirements.txt -U

# 6. OpenWebUI systemd-Dienst neu starten

sudo systemctl restart openwebui.service

# (optional) Update Ollama:

curl -fsSL https://ollama.com/install.sh | sh

sudo systemctl restart ollama.service

Support en Verdere Documentatie

Neem voor installatieondersteuning, configuratiehulp of probleemoplossing rechtstreeks contact op met de Trooper.AI support:

- E-mail: support@trooper.ai

- WhatsApp: +49 6126 9289991

Aanvullende bronnen en geavanceerde configuratiehandleidingen: