OpenWebUI & Ollama

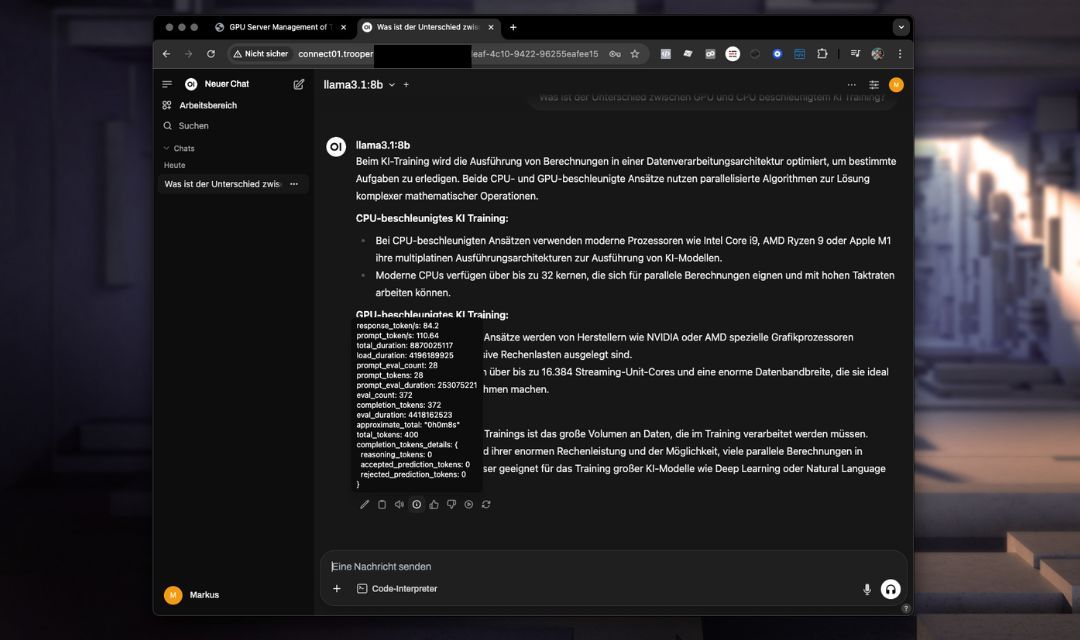

Der OpenWebUI & Ollama Die Vorlage bietet eine vorkonfigurierte, selbst gehostete KI-Chatoberfläche mit direkter Integration leistungsstarker Sprachmodelle wie Llama oder DeepSeek. Ollama Es beinhaltet eine optimierte Konfiguration für einen reibungslosen Betrieb ohne zusätzliche Konfiguration.

Diese Vorlage nutzt die erweiterten API-Funktionen von OpenWebUI und bietet so eine verbesserte Gesprächsverwaltung, Kontextpersistenz und eine optimierte Integration im Vergleich zur einfacheren API von Ollama.

Sie können die zu installierende Version von OpenWebUI angeben. Der Standardwert ist unsere zuletzt getestete Version, aber Sie können bei Bedarf upgraden oder downgraden. Geben Sie einfach Ihre gewünschte Version beim Wert der Konfiguration während der Template-Installation ein.

Hauptfunktionen und -fähigkeiten

- Erweiterte WeboberflächeIntuitive Chat-Erfahrung, die direkt über Ihren Browser zugänglich ist.

- Erweiterte API-FunktionenVerbesserte Verwaltung von Chat-Kontexten und einfachere Integration mit externen Anwendungen.

- Optimierte ModellnutzungVorkonfigurierte Modelle für die sofortige Verwendung.

- Integrierte UmgebungVollständig vorkonfigurierte Umgebung inklusive Porteinstellungen und notwendigen Konfigurationen.

- Sicher und anpassbarEinfache Einrichtung für sichere Zugangsdaten und benutzerspezifische Einstellungen.

Installation

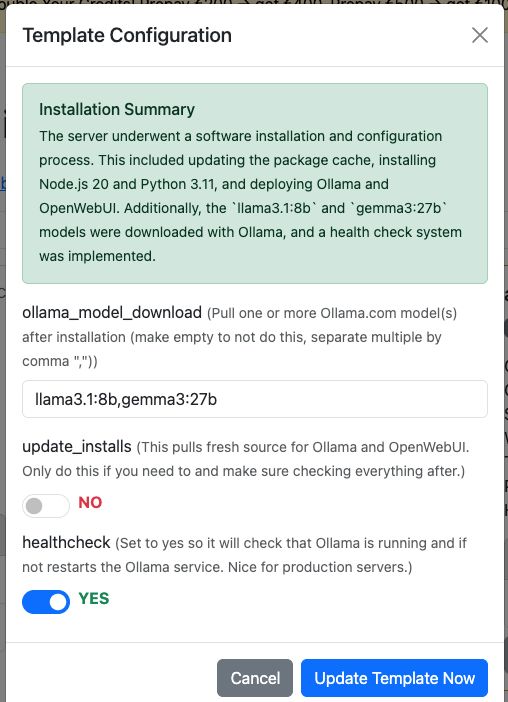

Fügen Sie einfach die Vorlage „OpenWebUI & Ollama“ zu Ihrem Trooper.AI GPU Server hinzu und die Installation erfolgt vollständig automatisch. Wenn Sie möchten, kann es Ihre Modelle auch direkt von ollama herunterladen. Sie können diese im Vorlagenkonfigurationsdialog konfigurieren.

Sie können Modelle natürlich auch nach der Installation über die OpenWebUI herunterladen.

Zusätzliche Optionen:

-

Installationen aktualisieren:

Diese Option lädt den neuesten Quellcode für Ollama und OpenWebUI herunter. Verwenden Sie diese nur, wenn es unbedingt erforderlich ist, und überprüfen Sie anschließend alles.

Selbstverständlich können Sie auch manuelle Pulls über das Terminal durchführen, sollten Sie dabei aber nicht vergessen, auch die Abhängigkeiten zu installieren.

Diese Funktion erledigt alles für Sie – bequem und automatisiert! -

Gesundheitscheck aktivieren:

Setze dies aufyesum eine Zustandsprüfung zu aktivieren, die sicherstellt, dass der Ollama-Dienst läuft und über seine interne API antwortet.

Wenn dies nicht der Fall ist, startet die Gesundheitsprüfung den Dienst automatisch neu.

Das Skript befindet sich unter/usr/local/bin/ollama-health.sh, und der Dienst kann mit gesteuert werden:

sudo service ollama-health stop/start/status.

Dies ist besonders nützlich für Produktionsserver.

Zugriff auf OpenWebUI

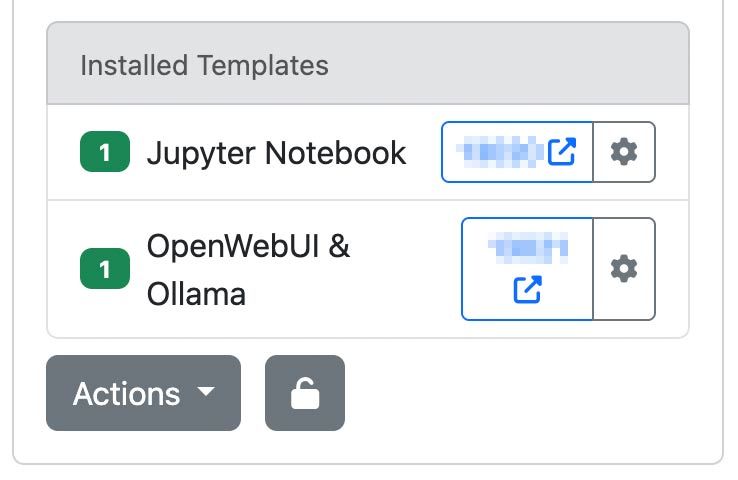

Nach dem Bereitstellen Ihrer Trooper.AI Serverinstanz mit der OpenWebUI & Ollama Vorlage, greifen Sie über die zugewiesene URL und den Port darauf zu:

http://your-hostname.trooper.ai:assigned-port

Oder klicken Sie auf die blaue Portnummer neben der OpenWebUI-Vorlage:

Sie konfigurieren die anfänglichen Anmeldedaten bei der ersten Verbindung. Stellen Sie sicher, dass Sie diese Anmeldedaten sicher aufbewahren, da sie für den späteren Zugriff erforderlich sind.

Empfohlene Anwendungsfälle

Die OpenWebUI & Ollama Vorlage eignet sich ideal für:

- Teamkollaboration via KI-Chat

- Bereitstellungen persönlicher KI-Assistenten

- Schnelle Entwicklung und Prototypenerstellung von Konversations-KI-Anwendungen

- API-Nutzung und Agenten-Erstellung/Verbindung als Ersatz für die OpenAI-API

- Bildungs- und Forschungszwecke

LLMs, die Sie testen sollten

Unserer Meinung nach sind hier ein paar Modelle, mit denen Sie beginnen können:

- GPT-OSS: OpenAI’s Open-Weight-Modell, geeignet für Reasoning, agentische Aufgaben und Entwicklung. Läuft effizient auf Explorer-, Conqueror- (16 GB VRAM) und Sparbox-Instanzen (24 GB VRAM). https://ollama.com/library/gpt-oss:20b

- DeepSeek-R1: Ein leistungsstarkes, offenes Reasoning-Modell, vergleichbar mit O3 und Gemini 2.5 Pro. Optimiert für StellarAI-Maschinen mit 48 GB VRAM. https://ollama.com/library/deepseek-r1:70b

- Gemma 3: Derzeit eines der leistungsfähigsten Modelle für die Nutzung mit einer einzelnen GPU. Betreibt James von Trooper.AI und Stell dir vor auf Sparbox-Instanzen. https://ollama.com/library/gemma3:27b

Hier finden Sie weitere LLMs: https://ollama.com/search (Diese sind alle mit OpenWebUI kompatibel!)

Technische Überlegungen

Systemanforderungen

Stellen Sie sicher, dass die VRAM-Auslastung Ihres Modells 85 % nicht überschreitet, um eine erhebliche Leistungsverschlechterung zu vermeiden.

- Empfohlene GPU-VRAM: 24 GB

- Speicher: Mindestens 180 GB verfügbarer Speicherplatz

Vorkonfigurierte Umgebung

- Ollama und OpenWebUI sind vorinstalliert und vollständig integriert.

- Porteinstellungen und alle notwendigen Konfigurationen sind bereits vorgenommen, sodass keine weitere manuelle Einrichtung erforderlich ist.

- Installationsverzeichnisse und Umgebungsvariablen sind vorkonfiguriert und sofort einsatzbereit.

Datenspeicherung

Alle Chat-Interaktionen, Modelleinstellungen und Benutzereinstellungen werden sicher auf Ihrem Server gespeichert.

Verbindung über eine OpenAI-kompatible API

OpenWebUI bietet eine OpenAI-kompatible API-Schnittstelle, die eine nahtlose Integration mit Tools und Anwendungen ermöglicht, die das OpenAI-Format unterstützen. Dies ermöglicht Entwicklern die Interaktion mit selbst gehosteten Modellen wie llama3 als ob sie mit der offiziellen OpenAI-API kommunizieren – ideal, um Konversations-KI in Ihre Dienste, Skripte oder Automatisierungsabläufe einzubetten.

Im Folgenden finden Sie zwei funktionierende Beispiele: eines mit Node.js und das andere mit curl.

Node.js Beispiel

const axios = require('axios');

const response = await axios.post('http://your-hostname.trooper.ai:assigned-port/v1/chat/completions', {

model: 'llama3',

messages: [{ role: 'user', content: 'Hello, how are you?' }],

}, {

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_API_KEY'

}

});

console.log(response.data);

cURL Beispiel

curl http://your-hostname.trooper.ai:assigned-port/v1/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "Hello, how are you?" }

]

}'

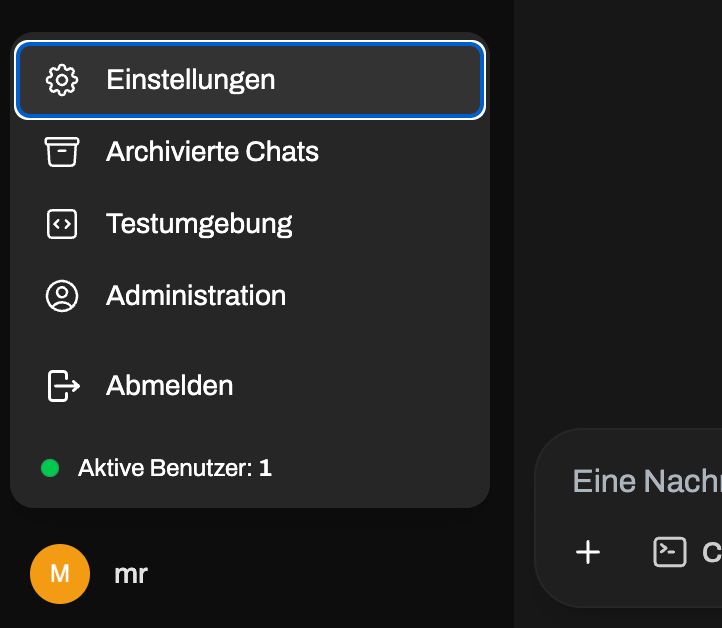

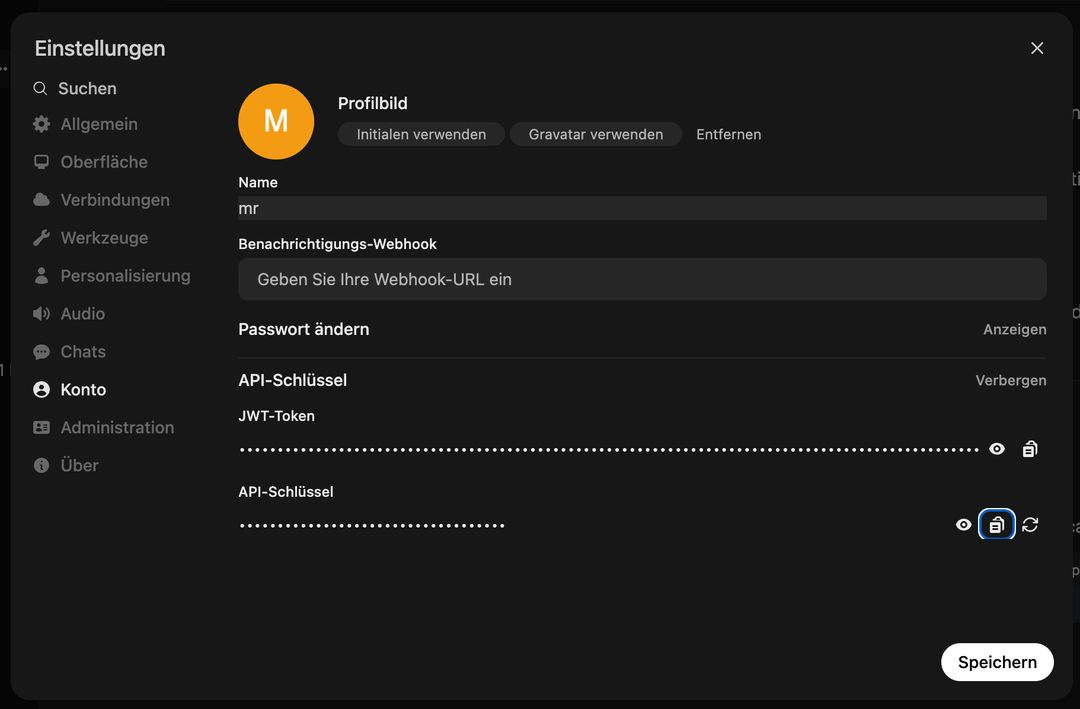

Ersetzen YOUR_API_KEY mit dem tatsächlichen Token, das in der OpenWebUI-Schnittstelle generiert wurde Benutzer → Einstellungen → Konto → API-SchlüsselGehen Sie nicht in das Admin-Panel, der API-Zugriff ist benutzerspezifisch! Siehe hier:

Gehen Sie danach hierher:

Sie können diese API mit Tools wie LangChain, LlamaIndex oder jeder Codebasis verwenden, die die OpenAI API-Spezifikation unterstützt.

Manuelle Aktualisierungen

Wenn Sie nicht über das Vorlagensystem aktualisieren möchten, können Sie jederzeit die folgenden Befehle ausführen, um sowohl OpenWebUI als auch Ollama zu aktualisieren:

# Update OpenWebUI:

# 1. Zum OpenWebUI-Verzeichnis wechseln

cd /home/trooperai/openwebui

# 2. Repository aktualisieren

git pull

# 3. Frontend-Abhängigkeiten installieren und neu bauen

npm install

npm run build

# 4. Backend: Python-Venv aktivieren

cd backend

source venv/bin/activate

# 5. Pip aktualisieren & Abhängigkeiten neu installieren

pip install --upgrade pip

pip install -r requirements.txt -U

# 6. OpenWebUI systemd-Dienst neu starten

sudo systemctl restart openwebui.service

# (optional) Update Ollama:

curl -fsSL https://ollama.com/install.sh | sh

sudo systemctl restart ollama.service

Support und weitere Dokumentation

Für Installationsunterstützung, Konfigurationshilfe oder Fehlerbehebung wenden Sie sich bitte direkt an den Trooper.AI Support:

- E-Mail: support@trooper.ai

- WhatsApp: +49 6126 9289991

Zusätzliche Ressourcen und erweiterte Konfigurationsanleitungen: