Jupyter Notebook

Diese Vorlage bietet eine sofort einsatzbereite, GPU-fähige Jupyter Notebook-Umgebung, die auf Ihrem Trooper.AI-Server vorinstalliert ist. Sie ist für eine nahtlose Nutzung konzipiert, einschließlich Data-Science-Workflows, der Entwicklung von KI-KI-Modellen, Prototyping und CUDA-aktivierter Berechnung.

Überblick über die Jupyter Notebook-Vorlage

Nach der Bereitstellung wird Jupyter Notebook als Systemdienst unter einem Nicht-Root-Benutzer ausgeführt. trooperaiDer Dienst ist nach einem Neustart immer verfügbar und erfordert keine manuelle Reaktivierung. Sie können sofort über die browserbasierte Oberfläche mit der Arbeit beginnen.

Hauptmerkmale

- Vorinstallierte Python-Umgebung unter Verwendung von virtualenv

- Integrierte GPU-Unterstützung mit optionaler CUDA/cuDNN-Installation

- Persistentes Arbeitsverzeichnis befindet sich unter

/home/trooperai - Start als Dienst: Jupyter läuft als Systemdienst und startet automatisch.

- Token- oder tokenloser Zugriff zur Vereinfachung der Sicherheit

- Einfaches Hochladen von Dateien in Ihren GPU Server Blib

- SSH-Terminal in Ihrem Webbrowser mit mehreren gleichzeitigen Sitzungen

Zugriff auf Jupyter Notebook

Nach der Bereitstellung weist Ihr GPU Server Blib automatisch einen verfügbaren öffentlichen Port zu. Um auf Jupyter Notebook zuzugreifen, öffnen Sie Ihren Browser und navigieren Sie zu:

http://your-hostname.trooper.ai:assigned-port

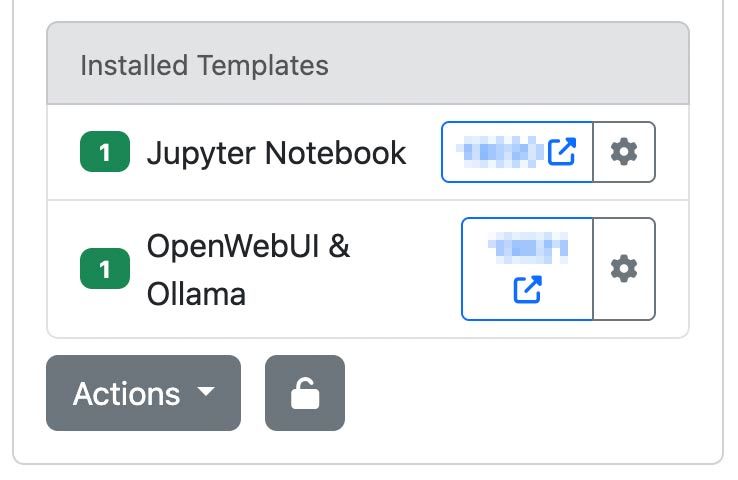

Sie finden die zugewiesene Portnummer neben der Vorlage in Ihren Serverdetails unter james.trooper.ai Siehe hier:

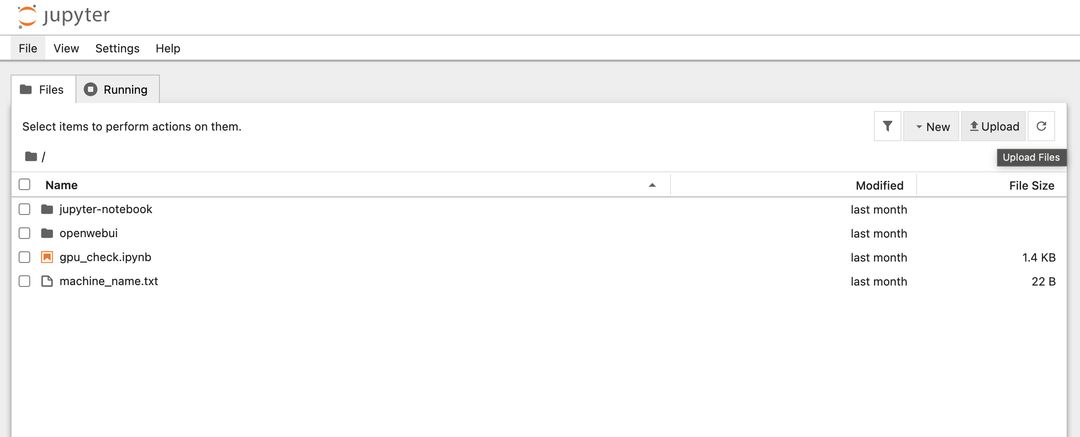

Nachdem Sie auf den Port geklickt haben, öffnet sich ein neues Browserfenster mit der Dateiliste des Home- oder Arbeitsbereichsordners:

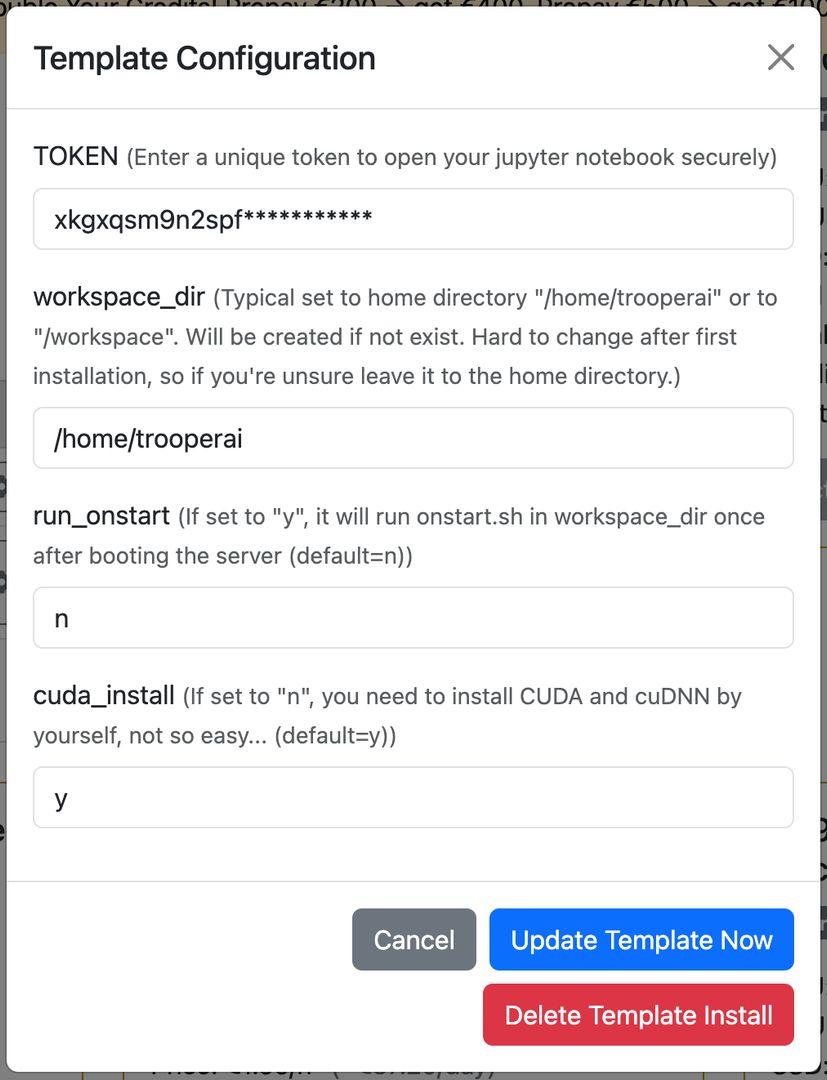

Wenn die Token-Authentifizierung aktiviert ist, fordert die Oberfläche beim ersten Zugriff einen Token an. Andernfalls ist das Notebook direkt verfügbar. In den meisten Fällen wird dieser Token automatisch an die URL angehängt, sodass Sie sich keine Sorgen um die Authentifizierung machen müssen. Sie können den Token in der Template-Konfiguration ändern oder zurücksetzen.

Jupyter öffnet das folgende Verzeichnis als seinen Root-Arbeitsbereich:

/home/trooperai

Sie können dies in der Template-Konfiguration ändern, siehe hier:

Wir empfehlen den Home-Ordner des Benutzers (Standard) oder /workspace.

Sie können auch die automatische Ausführung aktivieren onstart.sh in Ihrem Arbeitsordner beim Start des Servers, um Ihre App zu starten.

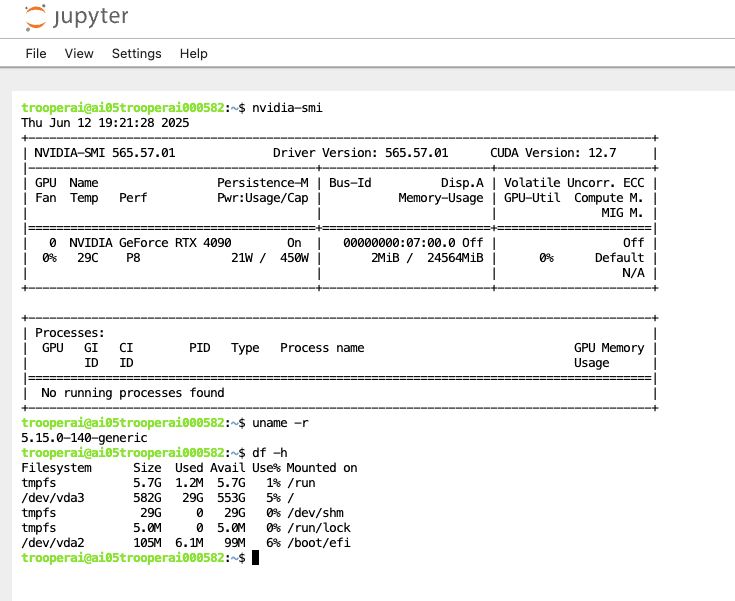

GPU-Verifizierung und CUDA-Unterstützung

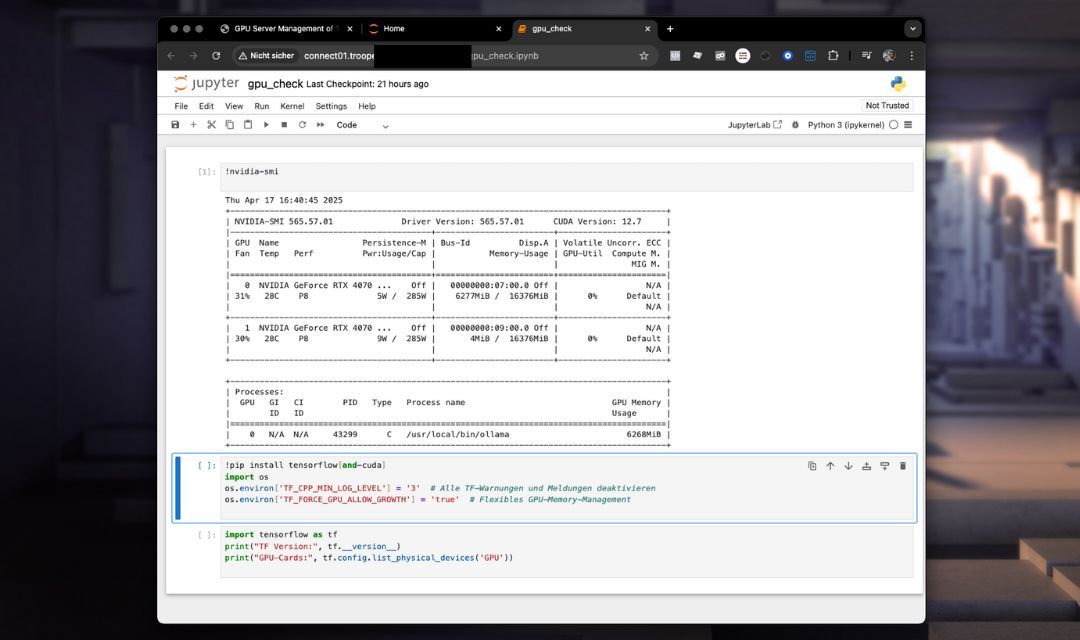

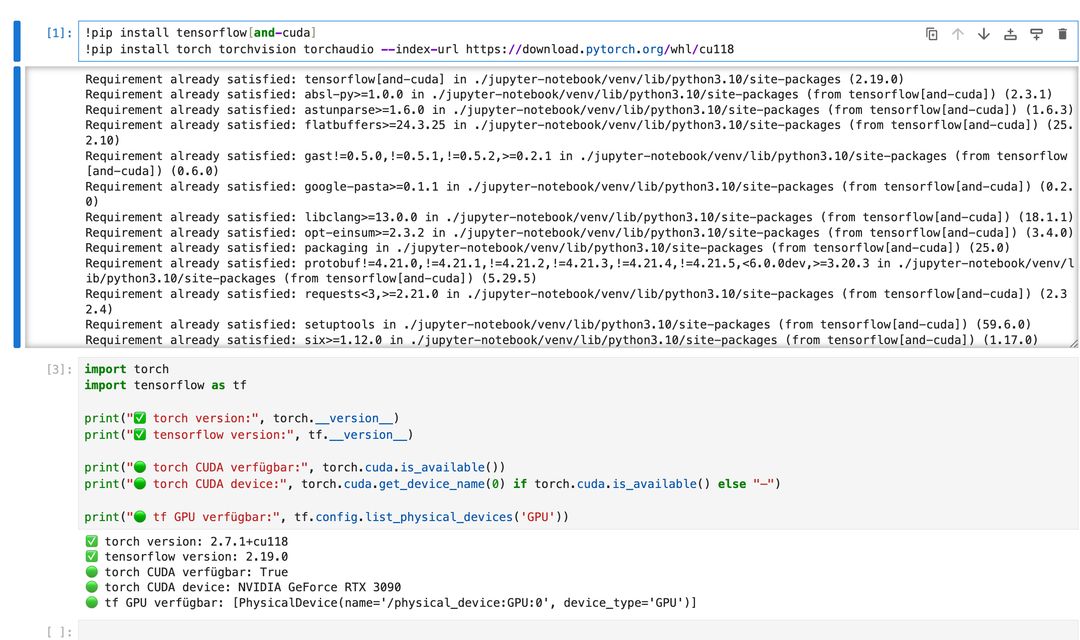

Die Vorlage enthält ein Notebook mit dem Namen gpu_check.ipynb um die Verfügbarkeit der GPU und die TensorFlow-Einrichtung zu überprüfen. Außerdem werden alle benötigten Tools für die CUDA-Nutzung in Python installiert.

Beispielinhalt von gpu_check.ipynb:

!nvidia-smi

!pip install tensorflow[and-cuda]

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '3'

os.environ['TF_FORCE_GPU_ALLOW_GROWTH'] = 'true'

import tensorflow as tf

print("TF Version:", tf.__version__)

print("GPU-Cards:", tf.config.list_physical_devices('GPU'))

Sie können dies erweitern, um andere Frameworks wie PyTorch oder JAX zu verwenden.

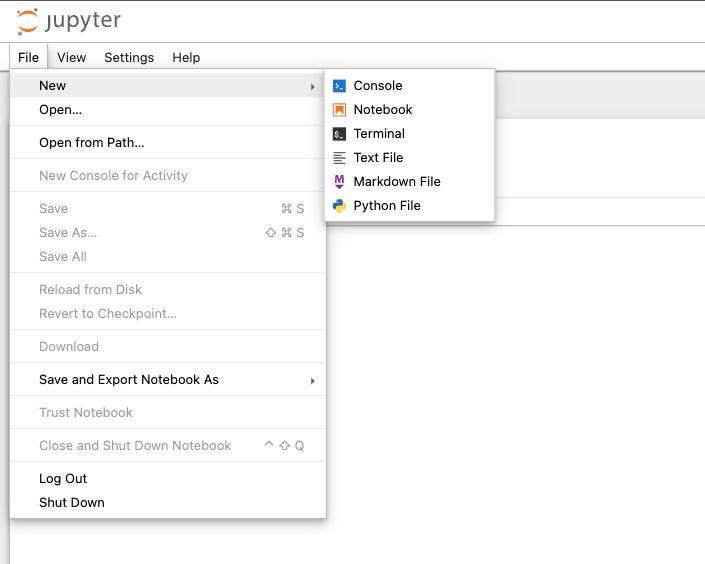

Terminal im Browser

Sie können ganz einfach eine Terminal-Sitzung in Jupyter Notebook öffnen, was persistent Bis zum Neustart! Wie großartig ist das? Selbst wenn Sie den Browser schließen, läuft es weiterhin in diesem Terminal, was immer Sie möchten. Sehr nützlich. Gehen Sie zu DATEI > NEUES Terminal wie hier:

Sie sehen ein Terminalfenster mit interaktiver Shell wie dieses:

Wir nutzen dies oft, um schnell etwas auf dem GPU-Server zu überprüfen.

Diese Terminal-Sitzungen laufen auch dann weiter, wenn Sie Ihren Browser schließen – es besteht keine Notwendigkeit für Tools wie

nohubum Prozesse am Laufen zu halten. Außerdem werden alle Ausgaben gespeichert, was das Prototyping erleichtert, ohne wertvolle Informationen zu verlieren.

Empfohlene Anwendungsfälle

- Datenexploration und -visualisierung

- Prototyping von Deep Learning und Machine Learning

- GPU-beschleunigte Trainings-Workflows

- Lehre und Workshops

- Dateien auf den GPU-Server hochladen und herunterladen

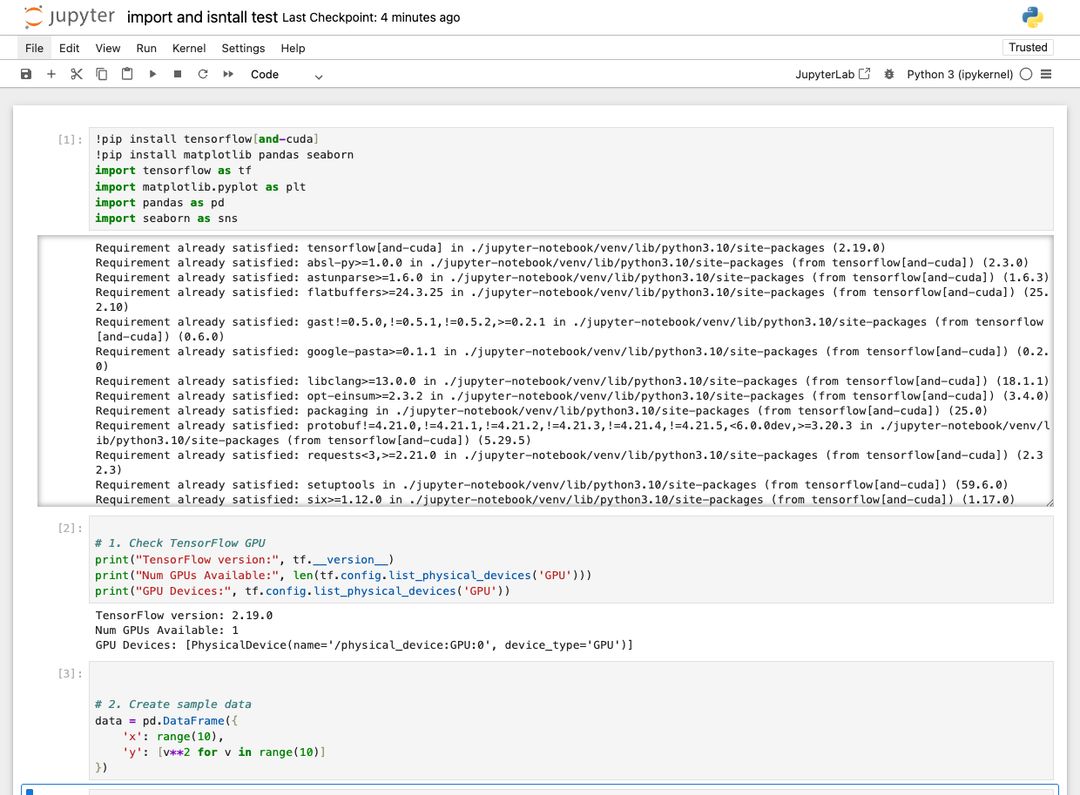

Importieren und Installieren Hilfe

Wenn Sie zusätzliche Bibliotheken in Ihr Jupyter Notebook installieren müssen, verwenden Sie einfach den Befehl !pip install wie folgt: !pip install Befehl wie folgt:

Dies prüft immer, ob alles installiert ist, und installiert es gegebenenfalls.

Wichtig: Stellen Sie immer sicher, dass Sie TensorFlow mit CUDA wie folgt installieren: !pip install tensorflow[and-cuda]Andernfalls funktioniert es nicht mit der GPU.

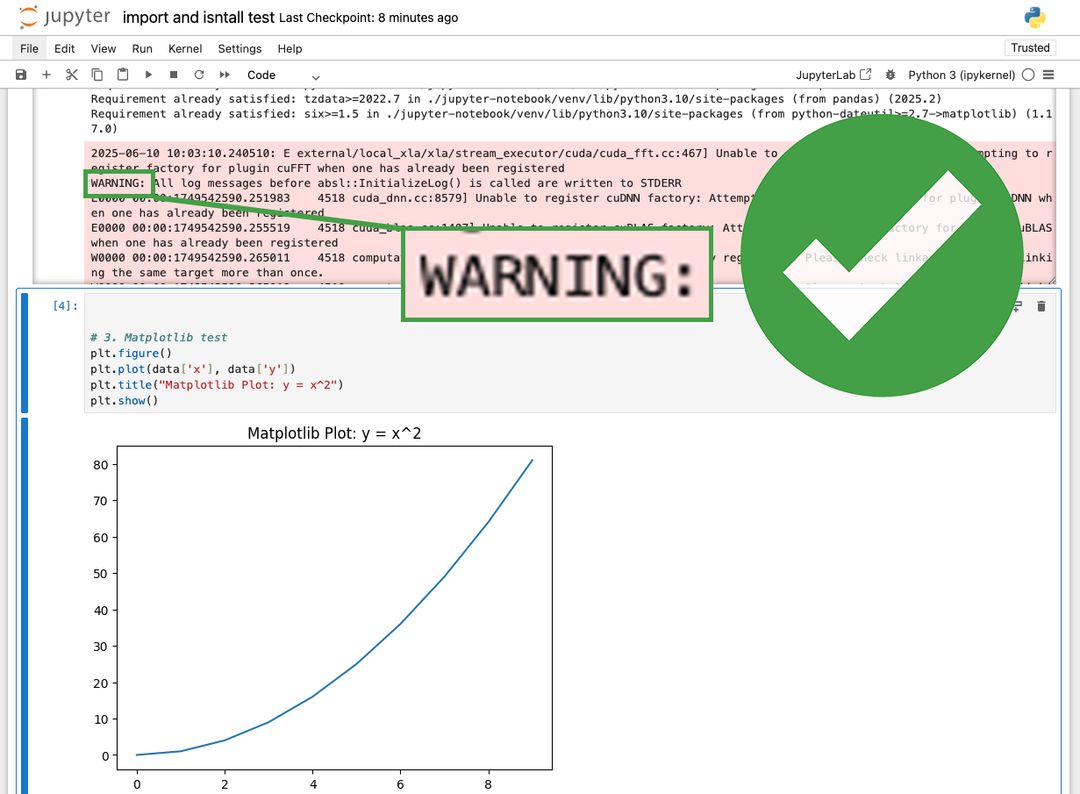

Habe ich Warnungen erhalten?

In Jupyter Notebook gibt es immer wieder Warnungen, die rot angezeigt werden. Diese sind meistens kein Problem. Siehe hier:

Sie sollten dies überprüfen und feststellen, ob die Warnung die GPU-Nutzung betrifft und ob die Leistung dadurch beeinträchtigt wird. Sie können Warnungen auch deaktivieren, dies ist jedoch von der Bibliothek abhängig und kann manchmal schwierig sein. Wir empfehlen, sie beizubehalten.

Systemdetails

Standardkonfiguration

- Jupyter Notebook-Oberfläche auf einem automatisch zugewiesenen Port

- Python virtuelle Umgebung in

~/jupyter-notebook/venv - Arbeitsverzeichnis:

/home/trooperai - Startet automatisch nach dem Neustart

Optionaler GPU-Stack

Wenn Ihre Instanz CUDA installiert hat, erkennt Jupyter automatisch die GPU-Unterstützung. CUDA 12.8 und cuDNN 9.8 sind mit TensorFlow-Kompatibilität verfügbar.

Anpassung & Startskript

Eine Datei namens onstart.sh ist in Ihrem Workspace enthalten. Es kann bearbeitet werden, um bei jedem Systemneustart benutzerdefinierte Shell-Befehle auszuführen. Um es zu aktivieren, kontaktieren Sie den Support, um die Ausführung von onstart zu ermöglichen.

Q&A

❓ Wie kann ich sowohl PyTorch als auch TensorFlow mit GPU-Unterstützung installieren? pip?

✅ Antwort:

Sie sollten installieren TensorFlow und PyTorch separat um CUDA-Abhängigkeitskonflikte zu vermeiden. Hier ist die empfohlene Vorgehensweise: pip:

# Install TensorFlow with GPU support

!pip install tensorflow[and-cuda]

# Then install PyTorch with CUDA 11.8 (example)

!pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

Do nicht kombinieren Sie beides in einem einzigen Pip-Befehl wie diesem:

# ❌ Not recommended — may cause conflicts!

!pip install torch tensorflow[and-cuda]

Installieren Sie diese stattdessen. getrenntin der richtigen Reihenfolge.

Nach der Installation testen Sie die GPU-Verfügbarkeit in Ihrem Notebook:

import torch, tensorflow as tf

print("Torch CUDA:", torch.cuda.is_available())

print("TF GPUs:", tf.config.list_physical_devices('GPU'))

❓ Wie installiere ich Pakete über pip über das Terminal, um es im Jupyter Notebook zu verwenden?

✅ Antwort:

Ihr Jupyter Notebook wurde mit einer dedizierten Python-Umgebung eingerichtet. Python virtuelle Umgebung! Sie müssen dies also ausführen pip aus dieser Umgebung im Terminal. Zum Beispiel:

/home/trooperai/jupyter-notebook/venv/bin/pip install tensorflow[and-cuda]

Um die Umgebung zu aktivieren und interaktiv zu installieren:

source /home/trooperai/jupyter-notebook/venv/bin/activate

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

Starten Sie nach der Installation Ihren Notebook-Kernel neu, um die neuen Pakete verfügbar zu machen.

Support

Für Installationsunterstützung, Token-Wiederherstellung oder Fehlerbehebung am Arbeitsbereich kontaktieren Sie:

- E-Mail: support@trooper.ai

- WhatsApp: +49 6126 9289991