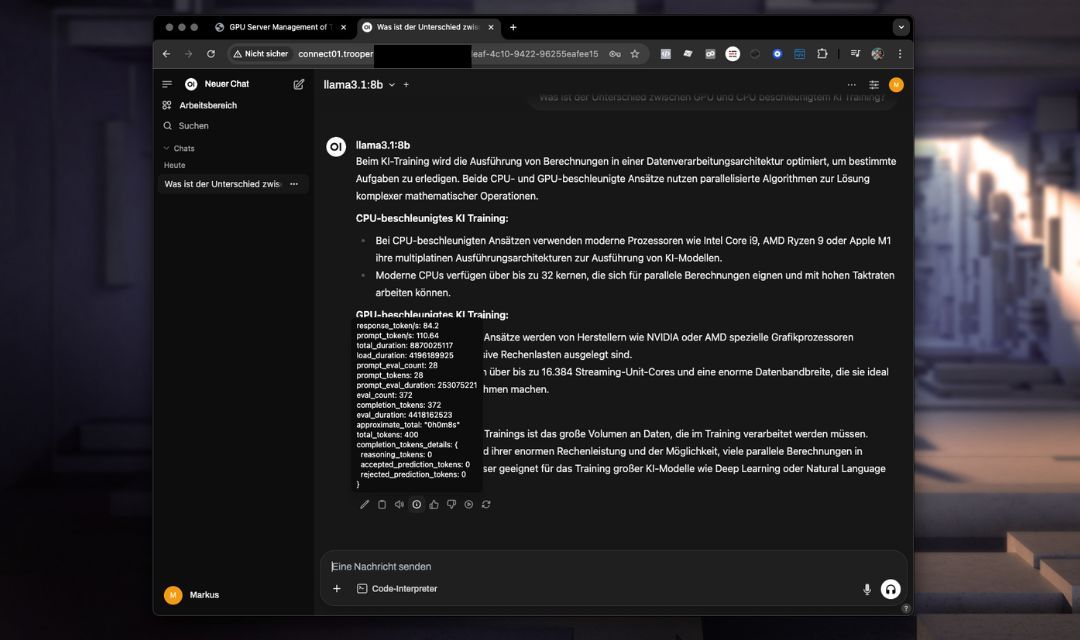

OpenWebUI i Ollama

Ten OpenWebUI i Ollama Szablon zapewnia prekonfigurowany, samodzielnie hostowany interfejs czatu AI z bezpośrednią integracją potężnych modeli językowych, takich jak Llama lub DeepSeek poprzez Ollama Zawiera zoptymalizowaną konfigurację zapewniającą bezproblemowe działanie bez dodatkowych ustawień.

Ten szablon wykorzystuje zaawansowane możliwości API OpenWebUI, zapewniając udoskonalone zarządzanie konwersacjami, trwałość kontekstu i usprawnioną integrację w porównaniu z prostszym API Ollama.

Możesz określić wersję OpenWebUI do zainstalowania. Domyślna wartość to nasza ostatnio przetestowana wersja; jednak możesz ją zaktualizować lub obniżyć w razie potrzeby. Po prostu wprowadź żądaną wersję w wartości konfiguracyjnej podczas instalacji szablonu.

Kluczowe funkcje i możliwości

- Zaawansowany interfejs webowyIntuicyjne doświadczenie czatowe dostępne bezpośrednio przez przeglądarkę.

- Rozszerzone możliwości APIUlepszone zarządzanie kontekstem czatu i łatwiejsza integracja z aplikacjami zewnętrznymi.

- Zoptymalizowane wykorzystanie modeliWstępnie zainstalowane modele gotowe do natychmiastowego użycia.

- Zintegrowane ŚrodowiskoW pełni skonfigurowane środowisko, w tym ustawienia portów i niezbędne konfiguracje.

- Bezpieczny i konfigurowalnyProsta konfiguracja bezpiecznych danych uwierzytelniających i ustawień specyficznych dla użytkownika.

Instalacja

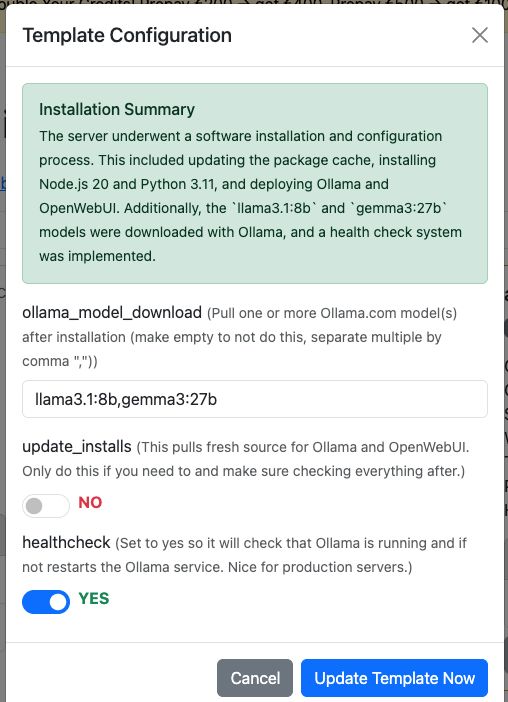

Wystarczy dodać szablon “OpenWebUI & Ollama” do swojego serwera GPU Trooper.AI, a instalacja przebiegnie całkowicie automatycznie. Jeśli chcesz, może również bezpośrednio pobierać modele z Ollama. Możesz je skonfigurować w oknie dialogowym Konfiguracji Szablonu.

Oczywiście, możesz nadal pobierać modele przez OpenWebUI po instalacji.

Dodatkowe opcje:

-

Aktualizuj instalacje:

Ta opcja pobiera najnowszy kod źródłowy dla Ollama i OpenWebUI. Użyj jej tylko w razie potrzeby i upewnij się, że wszystko zweryfikujesz później.

Oczywiście, możesz również ręcznie pobierać aktualizacje przez terminal, ale pamiętaj o zainstalowaniu zależności.

Ta funkcja załatwia wszystko za Ciebie – wygodne i zautomatyzowane! -

Aktywuj sprawdzanie stanu:

Ustaw to nayesaby włączyć sprawdzanie stanu, które zapewnia, że usługa Ollama działa i odpowiada przez jej wewnętrzne API.

W przeciwnym razie automatycznie uruchomi się ponownie sprawdzanie stanu usługi.

Skrypt znajduje się pod adresem/usr/local/bin/ollama-health.shi usługą można zarządzać za pomocą:

sudo service ollama-health stop/start/status.

Jest to szczególnie przydatne w przypadku serwerów produkcyjnych.

Dostęp do OpenWebUI

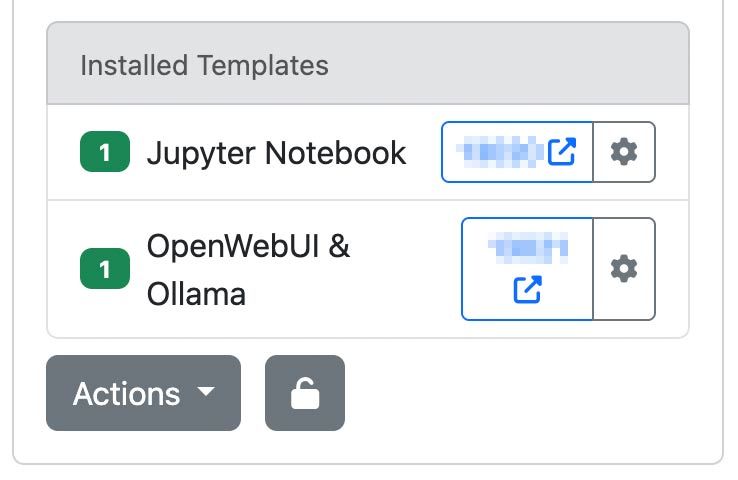

Po wdrożeniu instancji serwera Trooper.AI z szablonem OpenWebUI & Ollama, uzyskaj do niej dostęp za pomocą przypisanego adresu URL i portu:

http://your-hostname.trooper.ai:assigned-port

Lub kliknij na niebieski numer portu obok szablonu OpenWebUI:

Skonfigurujesz początkowe dane logowania przy pierwszym połączeniu. Upewnij się, że te dane są przechowywane w bezpiecznym miejscu, ponieważ będą wymagane do dalszego dostępu.

Zalecane przypadki użycia

Szablon OpenWebUI i Ollama jest idealny do:

- Współpraca zespołowa poprzez czat AI

- Wdrażanie osobistych asystentów AI

- Szybki rozwój i prototypowanie aplikacji konwersacyjnych AI

- Wykorzystanie API oraz budowanie/łączenie agentów jako zamiennik dla API OpenAI

- Cele edukacyjne i badania naukowe

Modele LLM, które warto przetestować

Z naszej perspektywy – oto kilka modeli, od których warto zacząć:

- GPT-OSS: Model o otwartych wagach OpenAI, odpowiedni do rozumowania, zadań agentowych i rozwoju. Wydajnie działa na instancjach Explorer, Conqueror (16 GB VRAM) i Sparbox (24 GB VRAM). https://ollama.com/library/gpt-oss:20b

- DeepSeek-R1: Wydajny, otwarty model rozumowania, porównywalny z O3 i Gemini 2.5 Pro. Zoptymalizowany dla maszyn StellarAI z 48 GB VRAM. https://ollama.com/library/deepseek-r1:70b

- Gemma 3: Obecnie jeden z najbardziej wydajnych modeli do wykorzystania na pojedynczej karcie GPU. Zasila James od Trooper.AI na instancjach Sparbox. https://ollama.com/library/gemma3:27b

Znajdź więcej LLM-ów tutaj: https://ollama.com/search (Wszystkie z nich są kompatybilne z OpenWebUI!)

Kwestie techniczne

Wymagania systemowe

Upewnij się, że wykorzystanie VRAM przez model nie przekracza 85% pojemności, aby zapobiec znacznemu pogorszeniu wydajności.

- Zalecana pamięć VRAM GPU: 24 GB

- Pamięć: Co najmniej 180 GB wolnej przestrzeni

Prekonfigurowane środowisko

- Ollama i OpenWebUI są wstępnie zainstalowane i w pełni zintegrowane.

- Ustawienia portów i wszystkie niezbędne konfiguracje zostały już skonfigurowane, co eliminuje potrzebę dalszej ręcznej konfiguracji.

- Katalogi instalacyjne i zmienne środowiskowe są zdefiniowane wstępnie, aby umożliwić natychmiastowe użycie.

Trwałość danych

Wszystkie interakcje z czatem, konfiguracje modeli i ustawienia użytkownika są bezpiecznie przechowywane na Twoim serwerze.

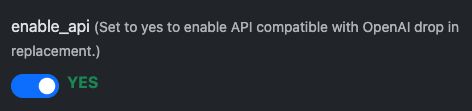

Połączenie przez API kompatybilne z OpenAI

OpenWebUI zapewnia interfejs API kompatybilny z OpenAI, umożliwiając bezproblemową integrację z narzędziami i aplikacjami obsługującymi format OpenAI. Pozwala to programistom na interakcję z modelami hostowanymi samodzielnie, takimi jak llama3 tak jakby komunikowali się z oficjalnym API OpenAI — idealne do osadzania sztucznej inteligencji konwersacyjnej w Twoich usługach, skryptach lub przepływach automatyzacji.

Pierwsze kroki: Przygotowanie

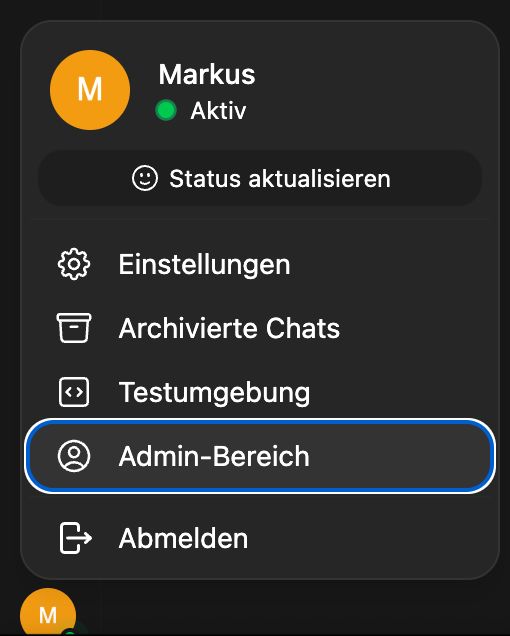

API jest domyślnie włączone, ale sprawdź w konfiguracji szablonu:

Po tym włącz tworzenie kluczy API dla wszystkich użytkowników:

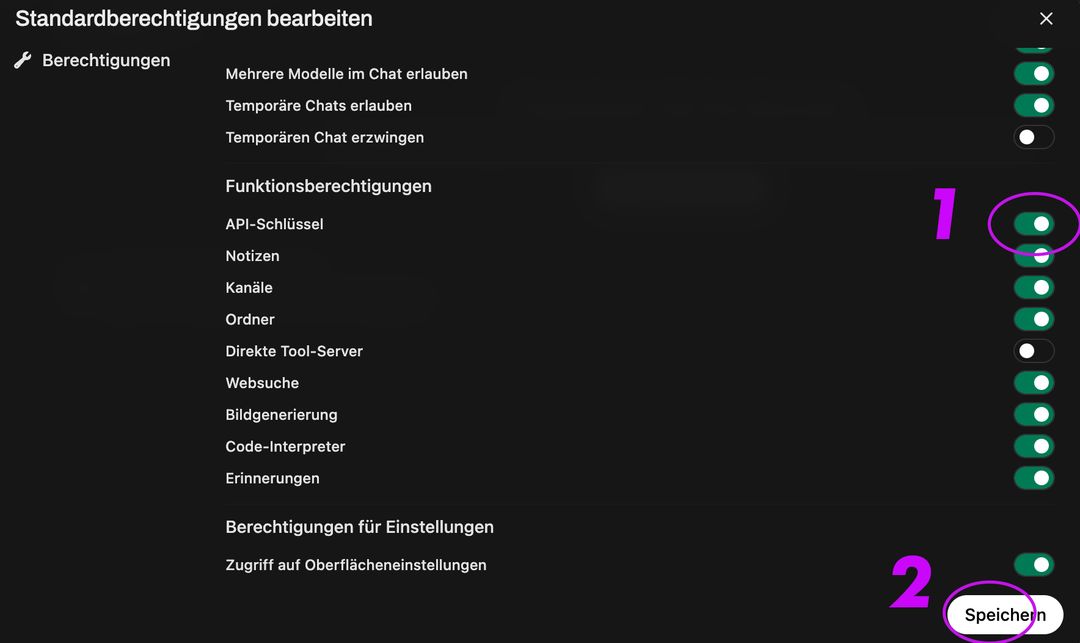

Następnie przejdź do Grupy i Domyślnej Grupy, aktywuj tworzenie klucza API, kliknij Zapisz:

To aktywuje punkt końcowy:

Poniżej znajdują się dwa przykłady: jeden wykorzystujący Node.js, a drugi używający curl.

Przykład Node.js

const axios = require('axios');

const response = await axios.post('https://your-secure-hostname.trooper.ai/api/chat/completions', {

model: 'llama3',

messages: [{ role: 'user', content: 'Hello, how are you?' }],

}, {

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_API_KEY'

}

});

console.log(response.data);

Upewnij się, że wywołania API wykorzystują

/api/...zamiast/v1/...ponieważ jest to wymagany format dla OpenWebUI.

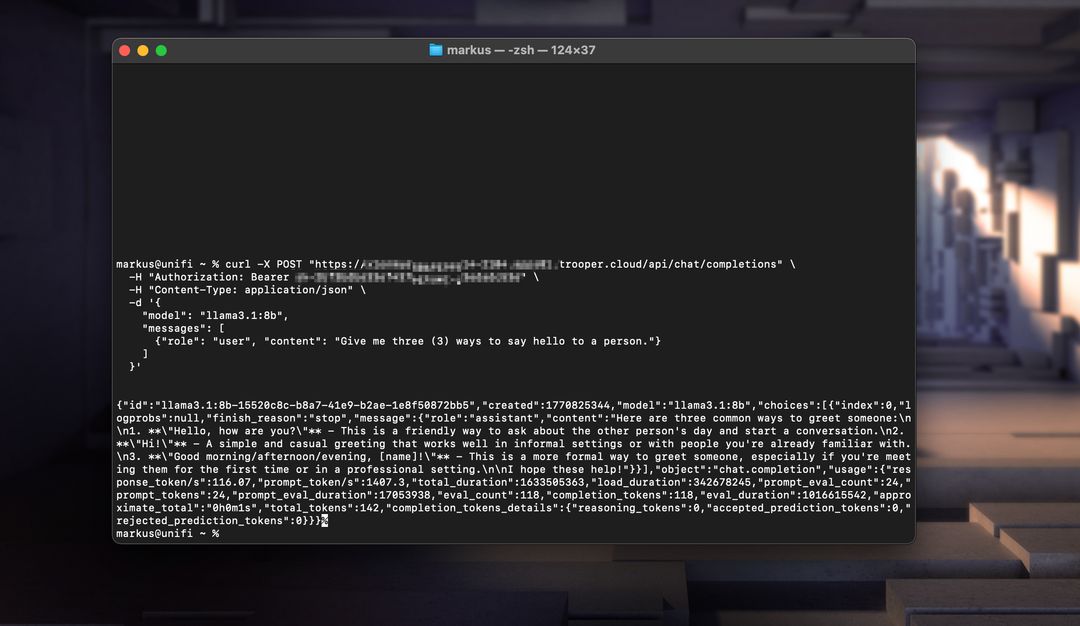

Przykład cURL

curl https://your-secure-hostname.trooper.ai/api/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "Hello, how are you?" }

]

}'

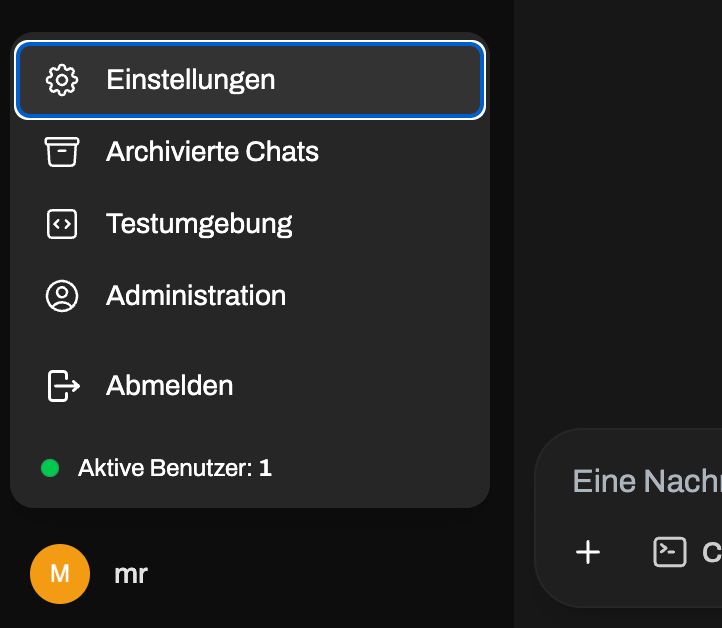

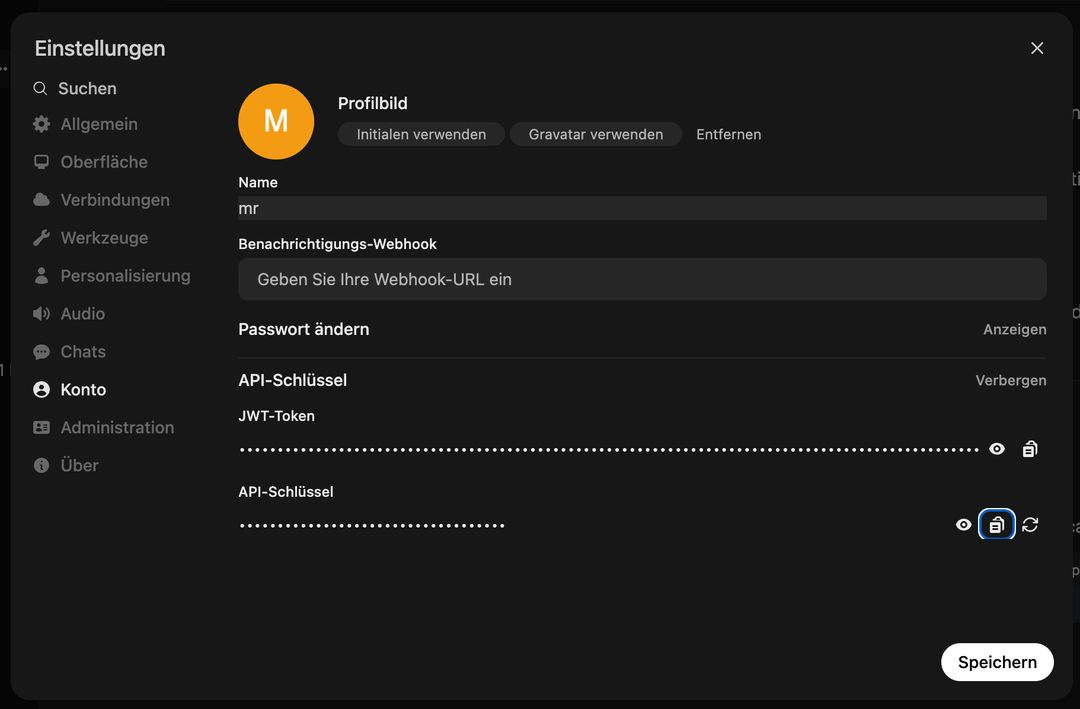

Zastąp YOUR_API_KEY z właściwym tokenem wygenerowanym w interfejsie OpenWebUI pod Użytkownik → Ustawienia → Konto → Klucze APINie wchodź do panelu administracyjnego, dostęp do API jest specyficzny dla użytkownika! Zobacz tutaj:

Po tym przejdź tutaj:

Możesz użyć tego API z narzędziami takimi jak LangChain, N8N, FlowWise, NodeJS-OpenAI, LlamaIndex, lub dowolnym kodem obsługującym specyfikację API OpenAI.

Aktualizacje ręczne

Jeśli nie chcesz aktualizować za pomocą systemu szablonów, możesz w dowolnym momencie uruchomić następujące polecenia, aby zaktualizować zarówno OpenWebUI, jak i Ollama:

# Update OpenWebUI:

# 1. Zum OpenWebUI-Verzeichnis wechseln

cd /home/trooperai/openwebui

# 2. Repository aktualisieren

git pull

# 3. Frontend-Abhängigkeiten installieren und neu bauen

npm install

npm run build

# 4. Backend: Python-Venv aktivieren

cd backend

source venv/bin/activate

# 5. Pip aktualisieren & Abhängigkeiten neu installieren

pip install --upgrade pip

pip install -r requirements.txt -U

# 6. OpenWebUI systemd-Dienst neu starten

sudo systemctl restart openwebui.service

# (optional) Update Ollama:

curl -fsSL https://ollama.com/install.sh | sh

sudo systemctl restart ollama.service

Wsparcie i dalsza dokumentacja

W razie potrzeby pomocy przy instalacji, konfiguracji lub rozwiązywaniu problemów, prosimy o bezpośredni kontakt z supportem Trooper.AI:

- Email: support@trooper.ai

- WhatsApp: +49 6126 9289991

Dodatkowe zasoby i zaawansowane przewodniki konfiguracyjne: