Notatnik Jupyter

Ten szablon zapewnia gotowe do użycia środowisko Jupyter Notebook z obsługą GPU, zainstalowane na Twoim serwerze Trooper.AI. Został zaprojektowany, aby zapewnić płynne działanie, w tym przepływy pracy związane z nauką o danych, tworzeniem modeli AI, prototypowaniem i obliczeniami z obsługą CUDA.

Przegląd szablonu Jupyter Notebook

Po wdrożeniu, Jupyter Notebook uruchamia się jako usługa systemowa pod użytkownikiem innym niż root. trooperaiUsługa jest zawsze dostępna po ponownym uruchomieniu i nie wymaga ręcznej reaktywacji. Możesz natychmiast rozpocząć pracę za pośrednictwem interfejsu przeglądarkowego.

Główne cechy

- Preinstalowane środowisko Python z użyciem virtualenv

- Zintegrowane wsparcie dla GPU z opcjonalną instalacją CUDA/cuDNN

- Trwały katalog roboczy znajdujący się pod adresem

/home/trooperai - Uruchamianie oparte na usłudze: Jupyter działa jako usługa systemowa i uruchamia się automatycznie

- Dostęp z tokenem lub bez tokena dla uproszczonego bezpieczeństwa

- Łatwe przesyłanie plików do Twojego GPU Server Blib

- Terminal SSH w Twojej przeglądarce z wieloma jednoczesnymi sesjami

Dostęp do Jupyter Notebook

Po wdrożeniu, Twój serwer GPU Blib automatycznie przypisuje dostępny port publiczny. Aby uzyskać dostęp do Jupyter Notebook, otwórz przeglądarkę i przejdź do:

http://your-hostname.trooper.ai:assigned-port

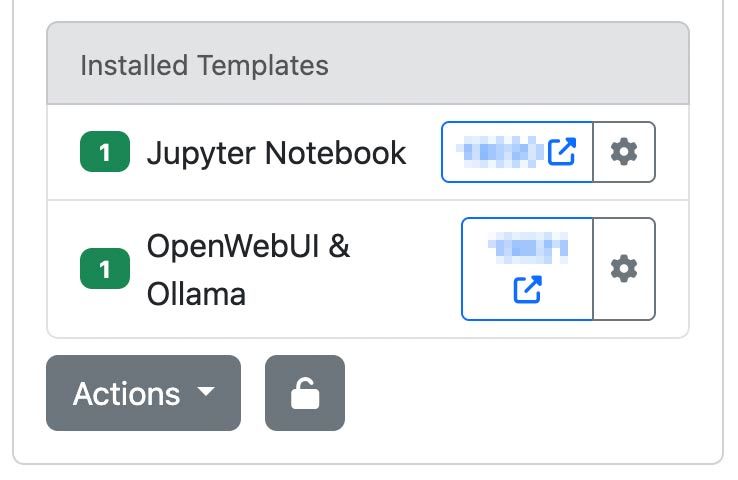

Numer przypisanego portu znajdziesz obok szablonu w szczegółach serwera na stronie james.trooper.ai Zobacz tutaj:

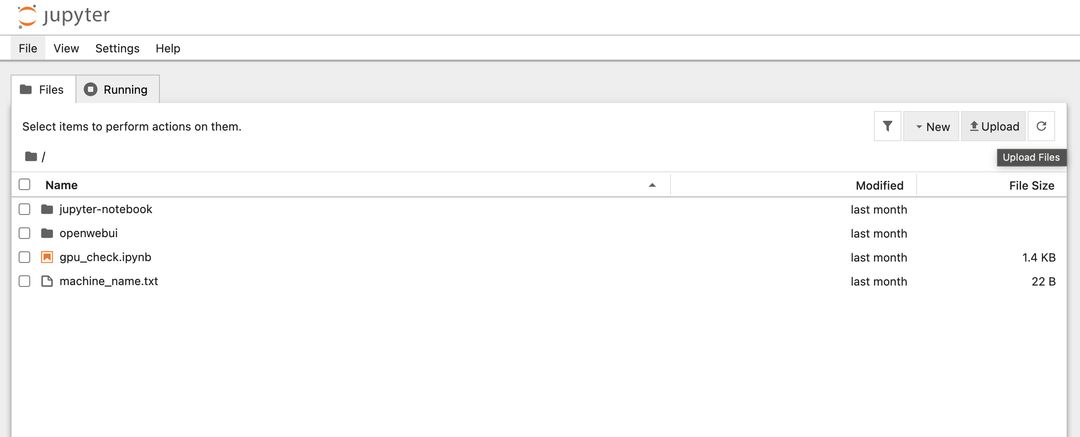

Po kliknięciu portu otworzy się nowe okno przeglądarki z listą plików katalogu domowego lub obszaru roboczego:

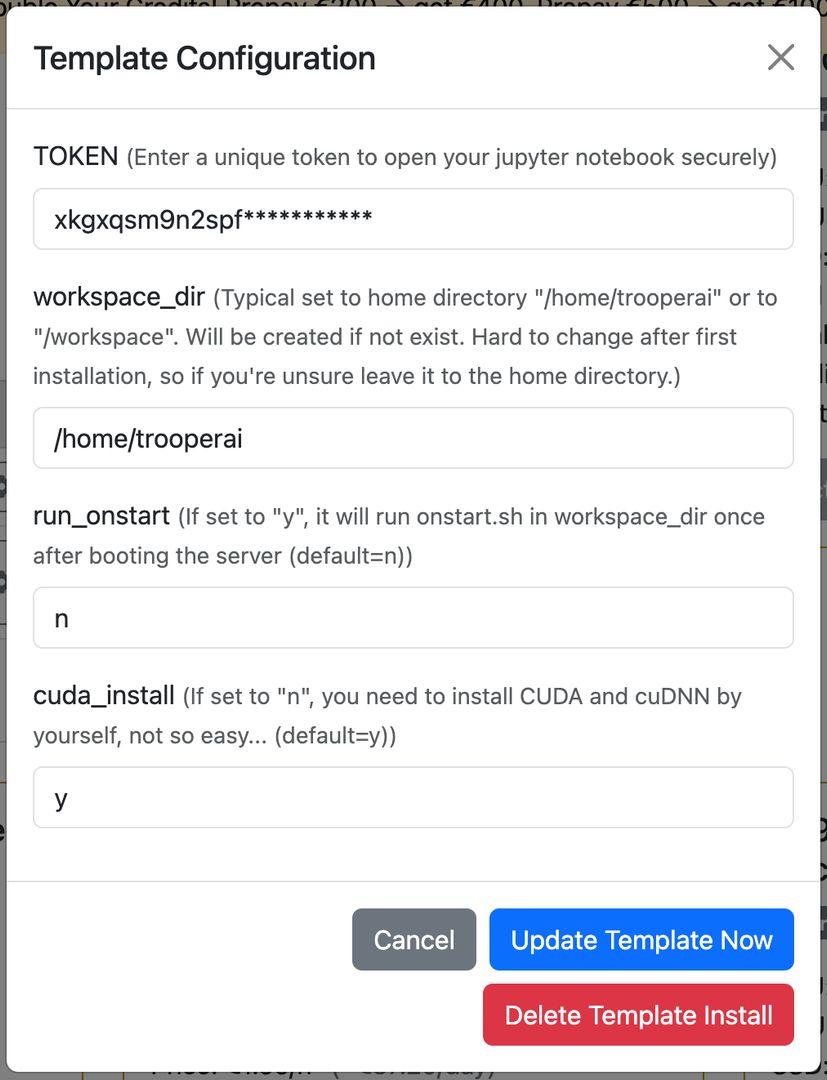

Jeśli włączona jest uwierzytelnianie tokenem, interfejs poprosi o token przy pierwszym dostępie. W przeciwnym razie notes będzie dostępny bezpośrednio. Zazwyczaj ten token jest automatycznie dodawany do adresu URL, więc nie musisz się martwić o uwierzytelnianie. Możesz zmienić lub zresetować token w Konfiguracji Szablonu.

Jupyter otwiera następujący katalog jako główny obszar roboczy:

/home/trooperai

Możesz to zmienić w Konfiguracji Szablonu, zobacz tutaj:

Polecamy folder domowy użytkownika (domyślnie) lub /workspace.

Możesz również aktywować automatyczne uruchamianie onstart.sh w Twoim folderze roboczym przy uruchomieniu serwera, aby uruchomić aplikację.

Weryfikacja GPU i obsługa CUDA

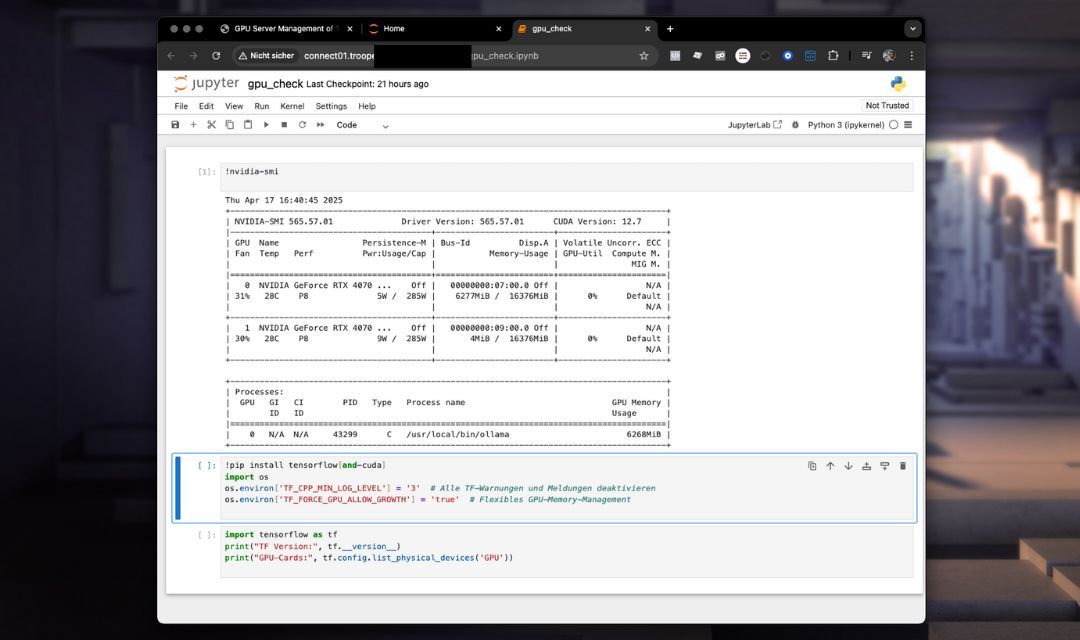

Szablon zawiera notes o nazwie gpu_check.ipynb aby zweryfikować dostępność GPU i konfigurację TensorFlow. Dodatkowo instaluje wszystkie niezbędne narzędzia do korzystania z CUDA w Pythonie.

Przykładowa zawartość gpu_check.ipynb:

!nvidia-smi

!pip install tensorflow[and-cuda]

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '3'

os.environ['TF_FORCE_GPU_ALLOW_GROWTH'] = 'true'

import tensorflow as tf

print("TF Version:", tf.__version__)

print("GPU-Cards:", tf.config.list_physical_devices('GPU'))

Możesz rozszerzyć to, aby korzystać z innych frameworków, takich jak PyTorch lub JAX.

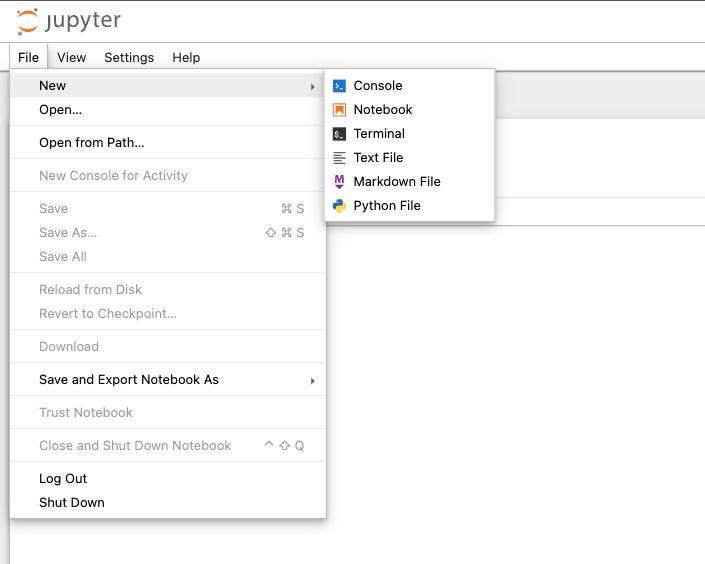

Terminal w przeglądarce

Możesz łatwo podłączyć sesję terminala w Jupyter Notebook, która trwały aż do ponownego uruchomienia! Jak to wspaniałe? Nawet jeśli zamkniesz przeglądarkę, nadal tam będzie działać w tym terminalu, co tylko chcesz. Bardzo przydatne. Przejdź do FILE > NEW Terminal jak tutaj:

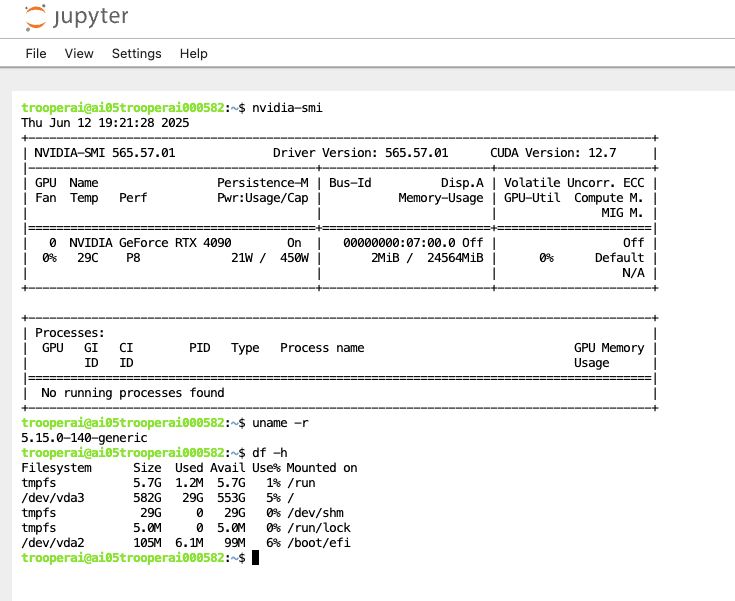

Zobaczysz okno terminala z interaktywną powłoką jak to:

Często używamy tego, aby szybko sprawdzić coś na serwerze GPU.

Te sesje terminala kontynuują działanie, nawet jeśli zamkniesz przeglądarkę – nie ma potrzeby używania narzędzi takich jak

nohubaby procesy działały w tle. Dodatkowo wszystkie dane wyjściowe są zapisywane, co ułatwia prototypowanie bez utraty cennych informacji.

Zalecane przypadki użycia

- Eksploracja i wizualizacja danych

- Prototypowanie uczenia głębokiego i uczenia maszynowego

- Workflowy szkoleniowe oparte na GPU

- Szkolenia i warsztaty

- Przesyłaj i pobieraj pliki na serwer GPU

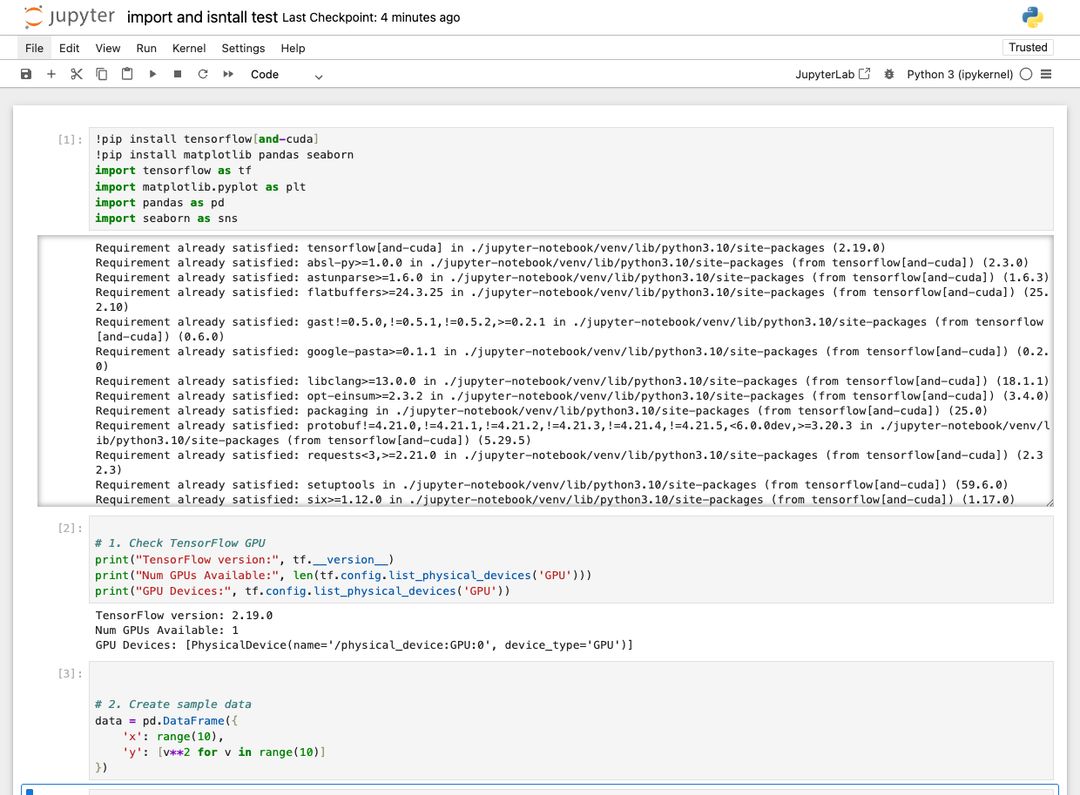

Import i pomoc w instalacji

Jeśli potrzebujesz zainstalować dodatkowe biblioteki w swoim Jupyter Notebook, po prostu użyj polecenia !pip install, na przykład: !pip install polecenie takie jak to:

Zawsze sprawdzi, czy wszystko jest zainstalowane, a jeśli nie, to to zrobi.

Ważne: Zawsze upewnij się, że instalujesz Tensorflow z CUDA, na przykład: !pip install tensorflow[and-cuda]W przeciwnym razie nie będzie to działać z GPU.

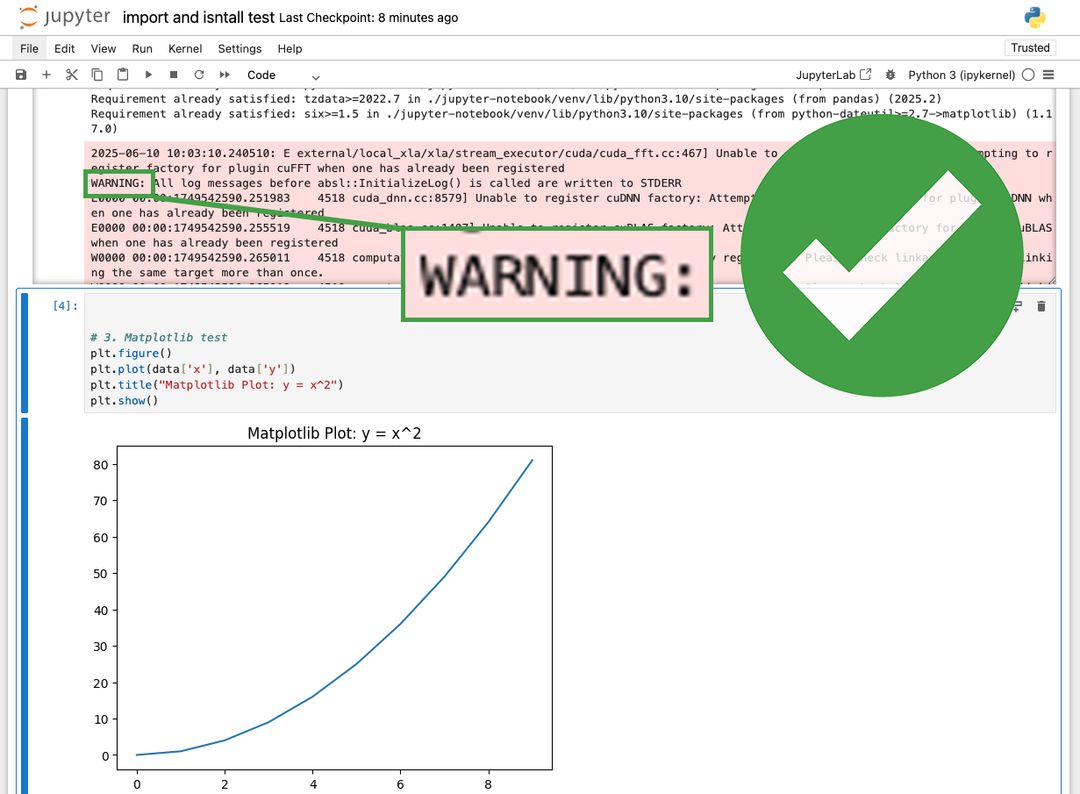

Czy pojawiły się ostrzeżenia?

W Jupyter Notebook zawsze pojawiają się ostrzeżenia w kolorze czerwonym. Zazwyczaj nie stanowią one problemu. Zobacz tutaj:

Warto to sprawdzić i upewnić się, czy ostrzeżenie dotyczy użycia GPU i czy nie obniża wydajności. Można również wyłączyć ostrzeżenia, ale zależy to od biblioteki i czasami jest to trudne. Zalecamy pozostanie przy nich.

Szczegóły systemu

Konfiguracja domyślna

- Interfejs Jupyter Notebook na automatycznie przypisanym porcie

- Środowisko wirtualne Python

~/jupyter-notebook/venv - Katalog roboczy:

/home/trooperai - Uruchamia się automatycznie po ponownym uruchomieniu

Opcjonalny stos GPU

Jeśli Twoja instancja ma zainstalowany CUDA, Jupyter automatycznie wykryje obsługę GPU. Dostępne są CUDA 12.8 i cuDNN 9.8 z kompatybilnością z TensorFlow.

Dostosowanie i skrypt uruchamiany przy starcie

Plik o nazwie onstart.sh jest zawarty w Twoim obszarze roboczym. Można go zmodyfikować, aby uruchamiać niestandardowe polecenia powłoki przy każdym uruchomieniu systemu. Aby go aktywować, skontaktuj się z działem wsparcia, aby włączyć wykonywanie skryptu onstart.

Q&A

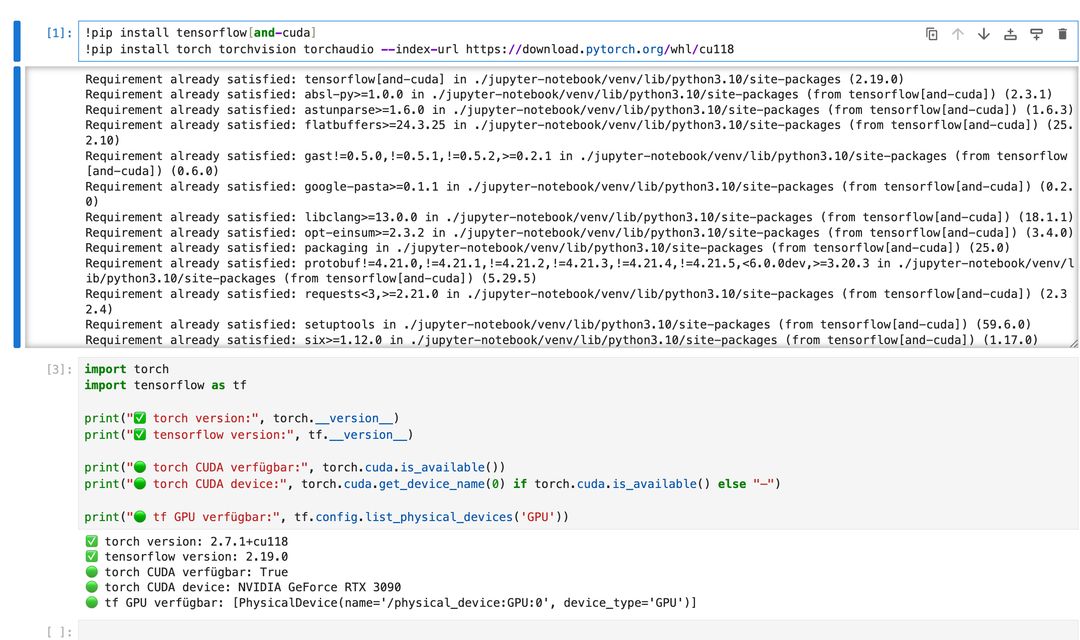

❓ Jak zainstalować zarówno PyTorch, jak i TensorFlow z obsługą GPU używając pip?

✅ Odpowiedź:

Powinieneś zainstalować TensorFlow i PyTorch oddzielnie aby uniknąć konfliktów zależności CUDA. Poniżej znajduje się zalecany sposób użycia pip:

# Install TensorFlow with GPU support

!pip install tensorflow[and-cuda]

# Then install PyTorch with CUDA 11.8 (example)

!pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

Do nie połączenie obu w jednym poleceniu pip, na przykład:

# ❌ Not recommended — may cause conflicts!

!pip install torch tensorflow[and-cuda]

Zamiast tego, zainstaluj je oddzielnie osobnow poprawnej kolejności.

Po instalacji przetestuj dostępność GPU w swoim notatniku:

import torch, tensorflow as tf

print("Torch CUDA:", torch.cuda.is_available())

print("TF GPUs:", tf.config.list_physical_devices('GPU'))

❓ Jak zainstalować pakiety przez pip przez terminal, aby użyć w Jupyter Notebook?

✅ Odpowiedź:

Twój Jupyter Notebook został skonfigurowany z wykorzystaniem dedykowanego Środowisko wirtualne PythonWięc musisz uruchomić pip z tego środowiska w terminalu. Na przykład:

/home/trooperai/jupyter-notebook/venv/bin/pip install tensorflow[and-cuda]

Aby aktywować środowisko i zainstalować interaktywnie:

source /home/trooperai/jupyter-notebook/venv/bin/activate

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

Po instalacji uruchom ponownie jądro swojego notebooka, aby nowe pakiety były dostępne.

Wsparcie

W przypadku problemów z instalacją, odzyskiwaniem tokenów lub rozwiązywaniem problemów z obszarem roboczym, skontaktuj się z:

- Email: support@trooper.ai

- WhatsApp: +49 6126 9289991