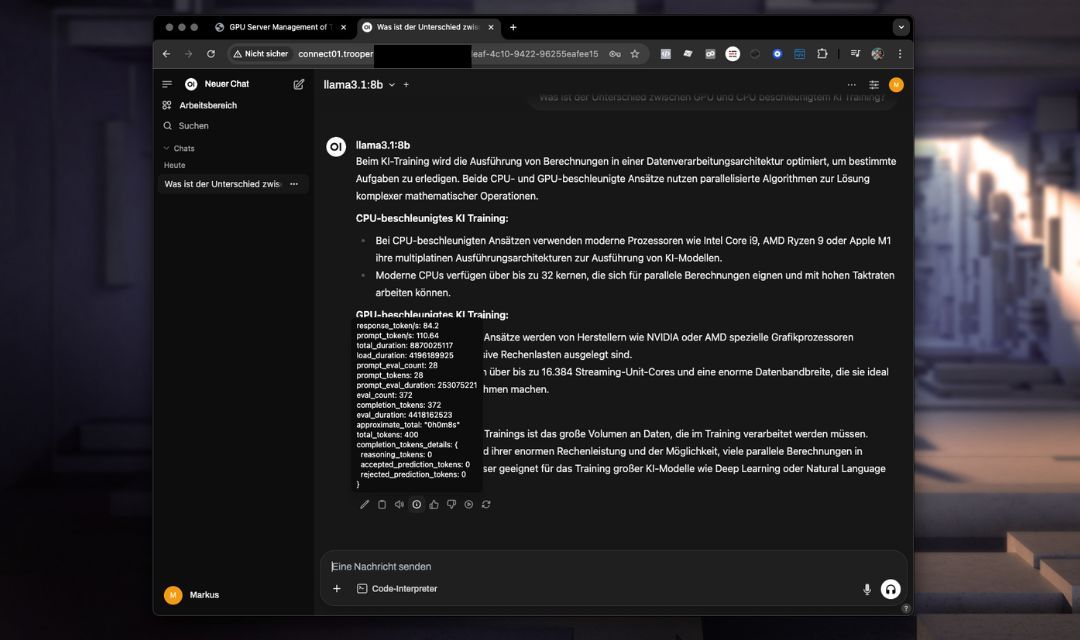

OpenWebUI & Ollama

The OpenWebUI & Ollama Skabelonen leverer en forudkonfigureret, selvhostet AI-chatgrænseflade med direkte integration af kraftfulde sprogmodeller som Llama eller DeepSeek via Ollama Det inkluderer en optimeret opsætning for problemfri drift uden yderligere konfiguration.

Denne skabelon udnytter de avancerede API-funktioner i OpenWebUI, hvilket giver forbedret samtaleadministration, kontekstvedholdelse og strømlinet integration sammenlignet med Ollamas enklere API.

Du kan angive den version af OpenWebUI, du vil installere. Standardværdien er vores senest testede version, men du er fri til at opgradere eller nedgradere efter behov. Indtast blot din ønskede version i konfigurationsværdien under skabeloninstallationen.

Nøglefunktioner og -muligheder

- Avanceret webgrænsefladeIntuitiv chatoplevelse tilgængelig direkte via din browser.

- Forbedrede API-funktionerForbedret håndtering af chatkontekster og nemmere integration med eksterne applikationer.

- Optimeret modelbrugForudinstallerede modeller klar til øjeblikkelig brug.

- Integreret miljøFuldt forkonfigureret miljø inklusive portindstillinger og nødvendige konfigurationer.

- Sikker og tilpasseligLigeudrettet opsætning af sikre legitimationsoplysninger og brugerdefinerede indstillinger.

Installation

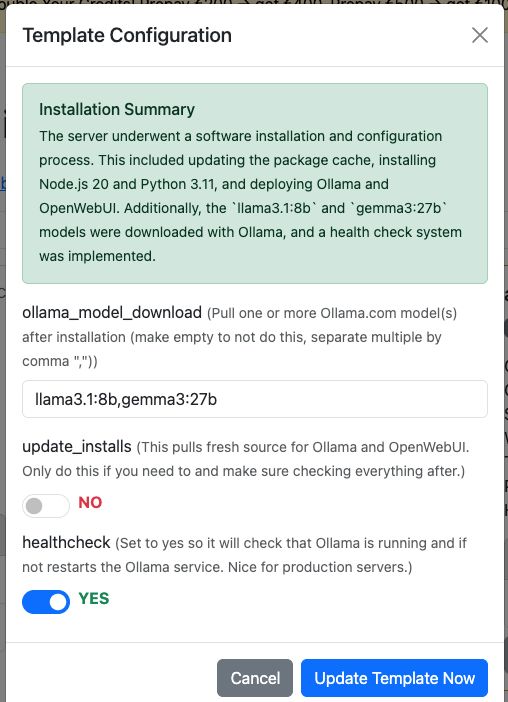

Tilføj blot skabelonen “OpenWebUI & Ollama” til din Trooper.AI GPU Server, og installationen vil foregå helt automatisk. Hvis du ønsker det, kan den også direkte downloade dine modeller fra ollama. Du kan konfigurere dem i skabelonkonfigurationsdialogen.

Men du kan selvfølgelig stadig downloade modeller via OpenWebUI efter installationen.

Yderligere muligheder:

-

Opdater installationer:

Denne mulighed henter den seneste kildekode for Ollama og OpenWebUI. Brug kun denne, hvis det er nødvendigt, og sørg for at verificere alt bagefter.

Du kan naturligvis også udføre manuelle pulls via terminalen, men husk at installere afhængighederne også.

Denne funktion håndterer alt for dig – bekvemt og automatiseret! -

Aktiver sundhedstjek:

Indstil dette tilyesfor at aktivere en sundhedstjek, der sikrer, at Ollama-tjenesten kører og svarer via dens interne API.

Hvis det ikke er tilfældet, genstarter sundhedstjekket automatisk tjenesten.

Scriptet er placeret på/usr/local/bin/ollama-health.shog tjenesten kan styres med:

sudo service ollama-health stop/start/status.

Dette er især nyttigt for produktionsservere.

Adgang til OpenWebUI

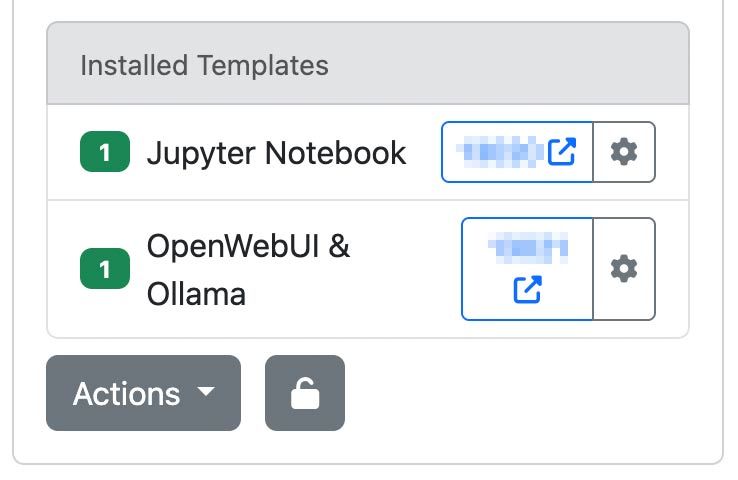

Efter implementeringen af din Trooper.AI serverinstans med OpenWebUI & Ollama skabelonen, kan du tilgå den via din tildelte URL og port:

http://your-hostname.trooper.ai:assigned-port

Eller klik på det blå portnummer ved siden af OpenWebUI-skabelonen:

Du vil konfigurere de indledende loginoplysninger ved din første forbindelse. Sørg for, at disse oplysninger opbevares sikkert, da de vil være nødvendige for efterfølgende adgang.

Anbefalede anvendelsesområder

OpenWebUI & Ollama-skabelonen er ideel til:

- Teamsamarbejde via AI-chat

- Personlige AI-assistentimplementeringer

- Hurtig udvikling og prototyper af samtale-AI-applikationer

- API-brug og opbygning/tilslutning af agenter som erstatning for OpenAI API

- Pædagogiske formål og forskningsaktiviteter

LLM'er du bør teste

Efter vores mening - her er et par modeller, du kan starte med:

- GPT-OSS: OpenAI's open-weight model, velegnet til ræsonnement, agentopgaver og udvikling. Kører effektivt på Explorer, Conqueror (16 GB VRAM) og Sparbox (24 GB VRAM) instanser. https://ollama.com/library/gpt-oss:20b

- DeepSeek-R1: En højtydende, åben ræsonnementsmodel, der kan sammenlignes med O3 og Gemini 2.5 Pro. Optimeret til StellarAI-maskiner med 48 GB VRAM. https://ollama.com/library/deepseek-r1:70b

- Gemma 3: I øjeblikket en af de mest kapable modeller til brug med et enkelt GPU. Driver Trooper.AI’s James på Sparbox-instanser. https://ollama.com/library/gemma3:27b

Find flere LLM'er her: https://ollama.com/search (Alle disse er kompatible med OpenWebUI!)

Tekniske overvejelser

Systemkrav

Sørg for, at din models VRAM-brug ikke overstiger 85 % af kapaciteten for at forhindre væsentlig ydelsesforringelse.

- Anbefalet GPU VRAM: 24 GB

- Lagring: Mindst 180 GB ledig plads

Forudkonfigureret miljø

- Ollama og OpenWebUI er forudinstalleret og fuldt integreret.

- Portindstillinger og alle nødvendige konfigurationer er allerede etableret, hvilket ikke kræver yderligere manuel opsætning.

- Installationsmapper og miljøvariabler er foruddefinerede for øjeblikkelig brug.

Datapersistens

Alle chatinteraktioner, modelkonfigurationer og brugerindstillinger gemmes sikkert på din server.

Forbindelse via OpenAI-kompatibelt API

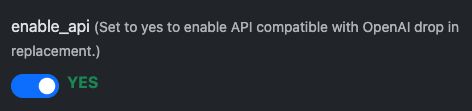

OpenWebUI leverer en API-grænseflade, der er kompatibel med OpenAI, hvilket muliggør problemfri integration med værktøjer og applikationer, der understøtter OpenAI-formatet. Dette giver udviklere mulighed for at interagere med selvhostede modeller som llama3 som om de kommunikerede med den officielle OpenAI API – ideelt til at integrere conversational AI i dine services, scripts eller automatiseringsflows.

Første trin: Forberedelse

API'et er aktiveret som standard, men tjek i skabelonkonfigurationen:

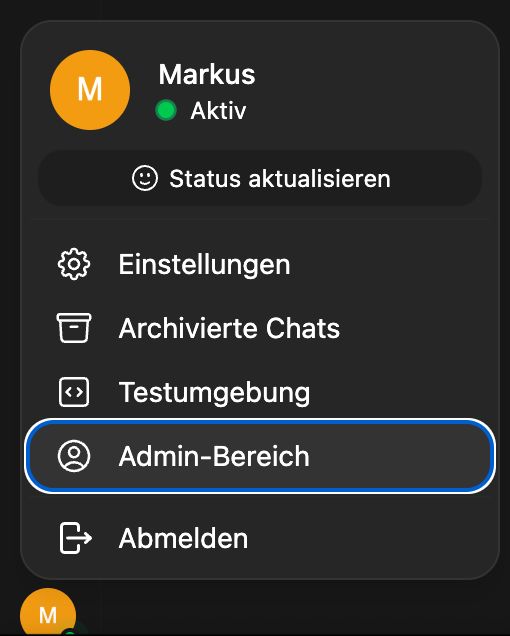

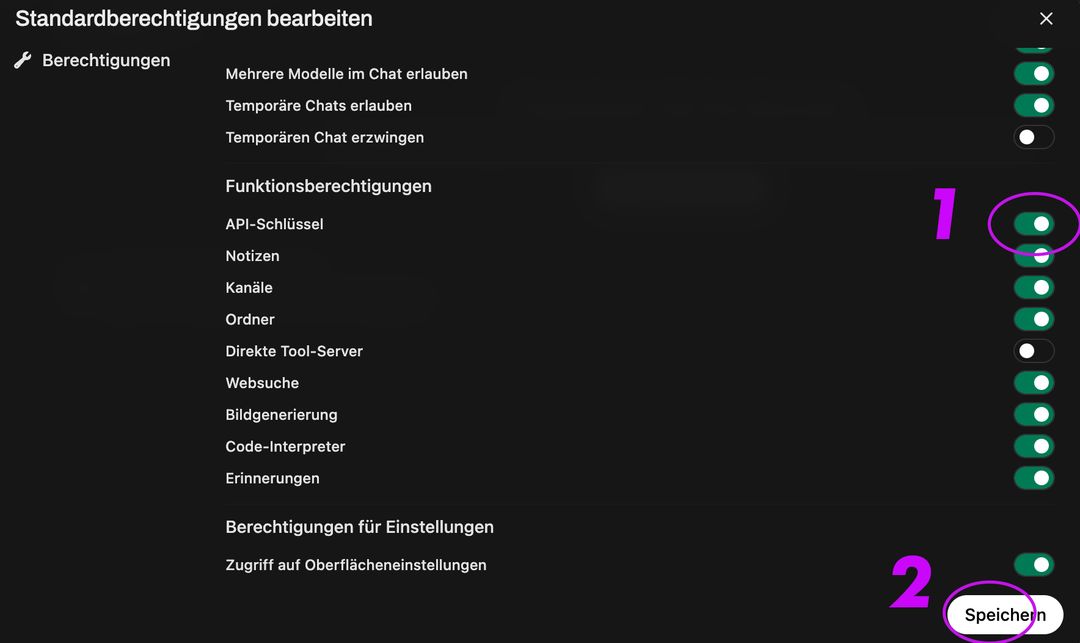

Efter dette skal du aktivere API-nøgleskabelse for alle brugere:

Gå derefter til Gruppe og Standardgruppe, aktiver API-nøgleoprettelse, klik på gem:

Dette vil aktivere endepunktet:

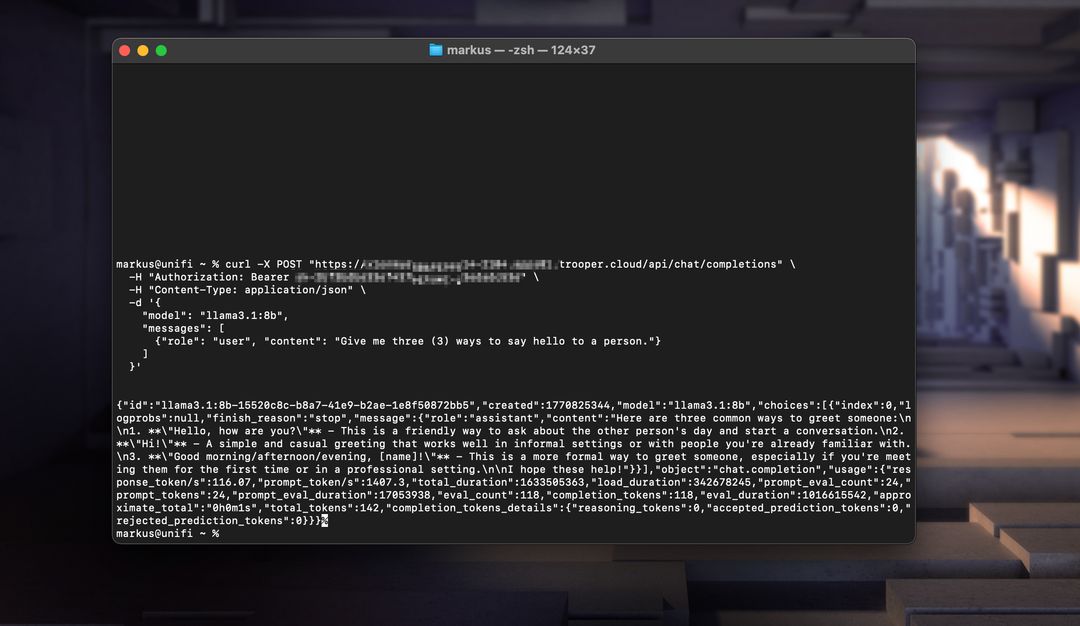

Her er to fungerende eksempler: et der bruger Node.js og et andet der bruger curl.

Node.js eksempel

const axios = require('axios');

const response = await axios.post('https://your-secure-hostname.trooper.ai/api/chat/completions', {

model: 'llama3',

messages: [{ role: 'user', content: 'Hello, how are you?' }],

}, {

headers: {

'Content-Type': 'application/json',

'Authorization': 'Bearer YOUR_API_KEY'

}

});

console.log(response.data);

Sørg for, at API-kald benytter

/api/...snarere end/v1/...da dette er det krævede format for OpenWebUI.

cURL Eksempel

curl https://your-secure-hostname.trooper.ai/api/chat/completions \

-H "Content-Type: application/json" \

-H "Authorization: Bearer YOUR_API_KEY" \

-d '{

"model": "llama3",

"messages": [

{ "role": "user", "content": "Hello, how are you?" }

]

}'

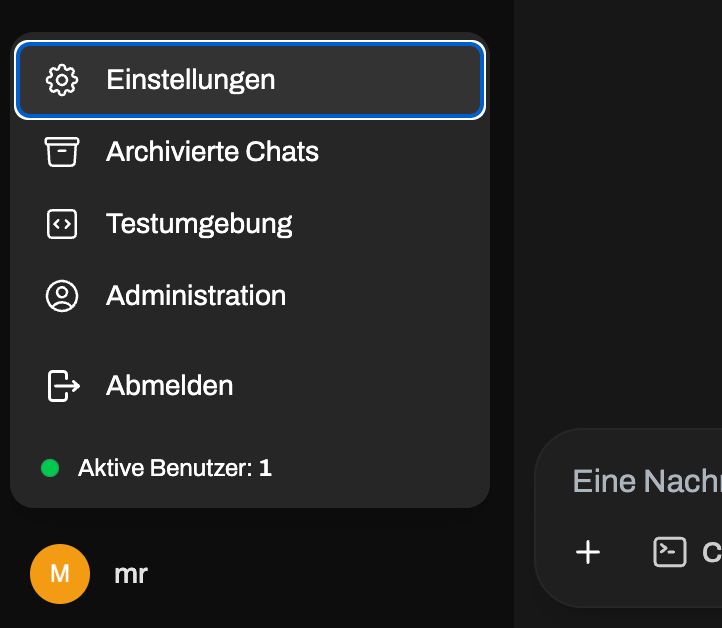

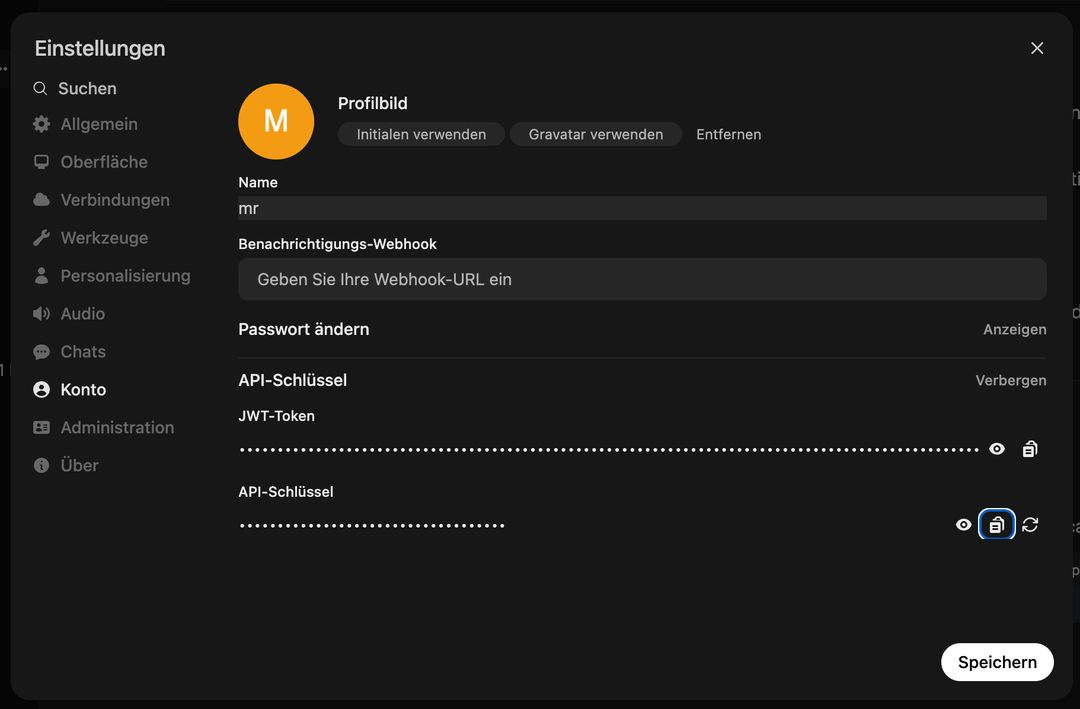

Erstat YOUR_API_KEY med den faktiske token genereret i OpenWebUI-grænsefladen under Bruger → Indstillinger → Konto → API-nøglerGå ikke ind i administrationspanelet, API-adgangen er brugerspecifik! Se her:

Gå herhen efter dette:

Du kan bruge dette API med værktøjer som LangChain, N8N, FlowWise, NodeJS-OpenAI, LlamaIndex, eller enhver kodebase, der understøtter OpenAI API-specifikationen.

Manuelle opdateringer

Hvis du ikke vil opdatere via skabelonsystemet, kan du til enhver tid køre følgende kommandoer for at opdatere både OpenWebUI og Ollama:

# Update OpenWebUI:

# 1. Zum OpenWebUI-Verzeichnis wechseln

cd /home/trooperai/openwebui

# 2. Repository aktualisieren

git pull

# 3. Frontend-Abhängigkeiten installieren und neu bauen

npm install

npm run build

# 4. Backend: Python-Venv aktivieren

cd backend

source venv/bin/activate

# 5. Pip aktualisieren & Abhängigkeiten neu installieren

pip install --upgrade pip

pip install -r requirements.txt -U

# 6. OpenWebUI systemd-Dienst neu starten

sudo systemctl restart openwebui.service

# (optional) Update Ollama:

curl -fsSL https://ollama.com/install.sh | sh

sudo systemctl restart ollama.service

Support og yderligere dokumentation

For installationssupport, konfigurationsassistance eller fejlfinding bedes du kontakte Trooper.AI support direkte:

- E-mail: support@trooper.ai

- WhatsApp: +49 6126 9289991

Yderligere ressourcer og avancerede konfigurationsvejledninger: